Quase todo mundo já passou pela mesma cena: você entra num site, aparece uma janelinha no canto da tela e, antes de falar com qualquer pessoa de carne e osso, uma “voz” digital pergunta se pode ajudar. Parece conversa, mas do outro lado não há um atendente humano. Há um programa. É disso que estamos falando quando usamos a palavra chatbot.

Mas o que exatamente é um chatbot hoje, num mundo de IA generativa, assistentes virtuais e modelos de linguagem gigantes? E, mais importante, até onde ele realmente ajuda e onde começa a dar dor de cabeça?

O que é um chatbot, afinal?

Na definição mais simples, um chatbot é um programa de computador que simula uma conversa com um usuário final. Ele responde a perguntas, orienta passos, tira dúvidas, tudo em um formato que lembra um bate-papo.

Nem todo chatbot usa inteligência artificial. Os mais antigos e simples funcionam como FAQs interativas: seguem árvores de decisão, menus e regras pré-definidas. Já os chatbots modernos vêm cada vez mais apoiados em técnicas de IA conversacional, como processamento de linguagem natural (NLP), para entender perguntas livres e gerar respostas de forma mais flexível.

A nova onda são os chatbots movidos por IA generativa, baseados em grandes modelos de linguagem (LLMs). Eles não apenas escolhem uma resposta pré-pronta, como eram os FAQ bots, mas geram conteúdo novo: texto, resumo, até descrições de imagens ou saídas de áudio, dependendo do sistema.

Essa diferença muda bastante o jogo. Em vez de programar um banco de respostas fixas para um conjunto fechado de perguntas, empresas podem conectar o chatbot diretamente à sua base de conhecimento (documentos, help center, políticas internas) e deixar a IA gerar respostas sob medida para uma variedade muito maior de questões.

Chatbots com IA generativa: mais do que “perguntas e respostas”

A próxima geração de chatbots corporativos caminha em direção a algo mais parecido com um atendente digital adaptável:

- compreende linguagem comum, cheia de gírias, erros de digitação e frases incompletas

- lida com perguntas complexas, que exigem juntar várias informações

- ajusta o tom ao estilo de conversa do usuário

- tenta demonstrar empatia em contextos de suporte ou reclamação

Não é à toa que muitos executivos já enxergam esses sistemas atendendo clientes diretamente nos próximos anos, em escala. Uma solução de IA generativa em nível corporativo permite automatizar autoatendimento, agilizar suporte e criar experiências mais consistentes nos vários canais digitais da empresa.

A diferença em relação à IA conversacional “clássica” é que, com a generativa, o chatbot deixa de apenas formular boas respostas e passa a criar conteúdo: textos explicativos, resumos, comparações de planos, descrições personalizadas e assim por diante, sempre baseado nos modelos em que foi treinado e nas fontes de dados conectadas.

E, em produtos mais avançados, esses chatbots são autoajustáveis: algoritmos de aprendizado analisam interações passadas para melhorar roteamento de conversa, escolher respostas mais úteis e reduzir atrito na experiência.

Onde os chatbots já estão (mesmo quando ninguém repara)

Na prática, chatbots deixaram de ser novidade. Eles aparecem:

- em smart speakers em casa

- em apps de mensagem como SMS, WhatsApp e Facebook Messenger

- em ferramentas de trabalho, como Slack e outros mensageiros corporativos

- em sites e aplicativos com aquelas bolhas de chat no canto da tela

Os mais sofisticados são chamados de assistentes virtuais inteligentes ou agentes virtuais. Eles não apenas conversam de forma mais natural, como conseguem executar tarefas: abrir um chamado, alterar uma senha, consultar um pedido, encaminhar um documento, atualizar um cadastro.

Ao lado de nomes conhecidos como Siri (Apple), Alexa (Amazon), Gemini (Google) e ChatGPT (OpenAI) no uso pessoal, agentes virtuais vêm ganhando espaço em contextos empresariais para apoiar clientes e também funcionários.

Um exemplo simples: integrar um chatbot ao Microsoft Teams para virar um hub de produtividade, onde se consegue, sem sair da conversa, puxar documentos, marcar reuniões, consultar status de pedidos ou acessar sistemas internos com comandos em linguagem natural.

Em cenários mais avançados, chatbots corporativos se conectam a sistemas críticos (CRM, ERP, ferramentas internas) e orquestram fluxos de trabalho que atravessam vários aplicativos. Algo tão simples quanto trocar uma senha ou tão complexo quanto disparar um processo de aprovação com múltiplas etapas pode ser iniciado e acompanhado pela interface do chatbot.

Além disso, as próprias conversas viram fonte de dados. Analytics conversacional permite extrair insights de linguagem natural: principais dores dos clientes, motivos de contato, gargalos no fluxo, termos que geram confusão, oportunidades de melhoria de produto ou serviço.

No marketing, isso faz diferença, chatbots disponíveis 24/7 permitem conversas contínuas com o cliente, coletam pistas sobre comportamento de compra, preferências, objeções e oferecem experiências mais personalizadas ao longo de todo o funil digital.

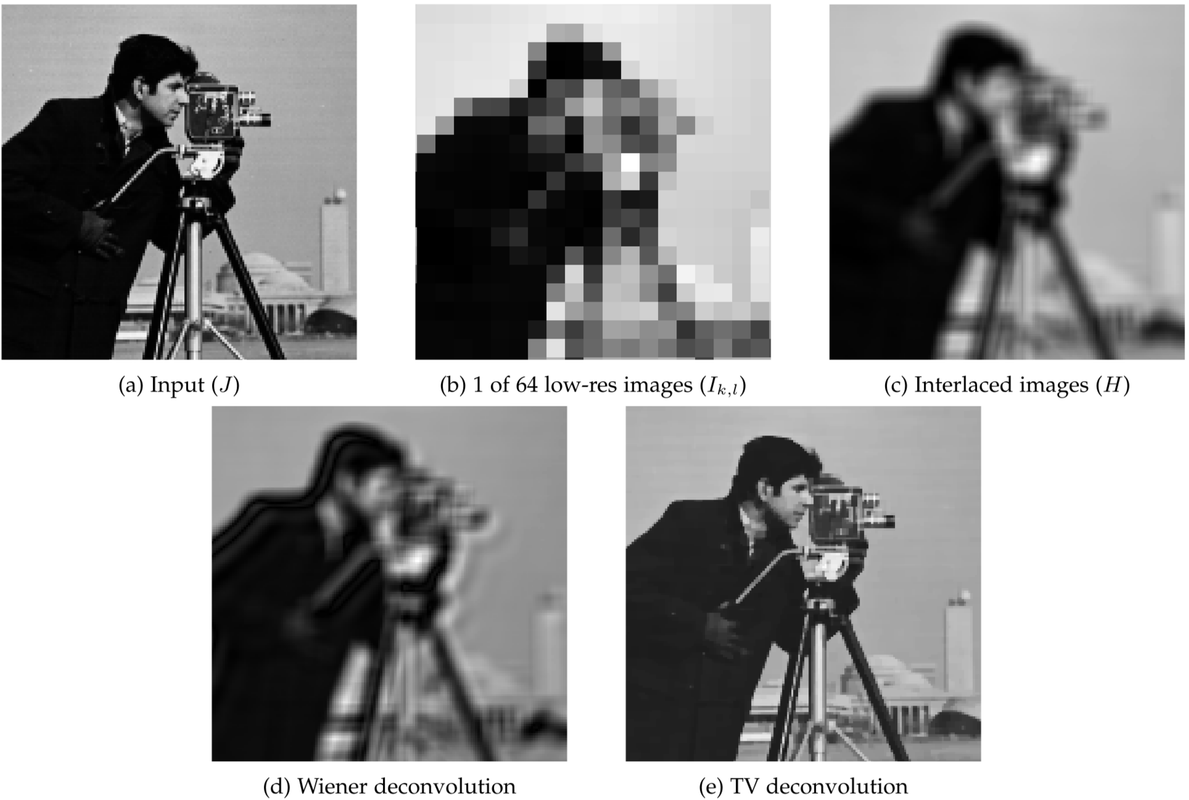

Como os chatbots funcionam: da FAQ rígida à conversa fluida

Os primeiros chatbots eram, basicamente, FAQs interativas. Uma lista de perguntas mais comuns, cada uma com sua resposta fixa, e uma camada de interface para ajudar o usuário a selecionar o que queria.

Sem entender linguagem natural, esses bots dependiam de palavras-chave ou menus. Se a pergunta não batesse com as opções previstas, ou fugisse muito do script, o sistema travava. Qualquer desvio da “forma oficial” da pergunta fazia a conversa desandar.

Com o tempo, os algoritmos evoluíram. Entraram regras mais complexas, fluxos mais sofisticados, e depois NLP (processamento de linguagem natural) e machine learning. Surgiram chatbots capazes de interpretar frases em linguagem mais livre, reconhecer intenções, lidar com variações na forma de perguntar.

Hoje, chatbots com IA combinam:

- NLU (Natural Language Understanding), para entender o significado do que foi escrito ou dito, mesmo com erros ou sotaques

- modelos que identificam a intenção do usuário (o que ele quer fazer)

- mecanismos de geração de resposta, que usam IA conversacional para formular a saída em linguagem natural

- técnicas de machine learning e deep learning, alimentadas por dados de interações anteriores, para melhorar continuamente o entendimento

Os avanços em grandes modelos de linguagem (LLMs) deixaram essa combinação ainda mais potente, permitindo respostas mais contextuais, com menos engessamento e maior capacidade de generalização.

O tempo para construir um chatbot desses varia bastante. Depende da pilha de tecnologia, das integrações necessárias, da complexidade das tarefas, dos dados já disponíveis e da exigência de personalização. Plataformas de no-code e low-code encurtam esse caminho, permitindo montar e treinar chatbots básicos em bem menos tempo, principalmente para casos padronizados.

Chatbot, chatbot de IA e agente virtual: não é tudo a mesma coisa

Na prática, os termos se misturam, e isso gera confusão. Vale separar:

- Chatbot é o guarda-chuva mais amplo. Qualquer software que simula conversa, desde um menu telefônico com reconhecimento limitado até um sistema de IA avançado, entra nessa categoria.

- Chatbot de IA é o chatbot que usa técnicas de inteligência artificial: machine learning para aprender com dados, NLP/NLU para entender linguagem, deep learning para melhorar a precisão ao longo do tempo. É o que permite conversas mais naturais, sem exigir que o usuário fale “como robô”.

- Agente virtual é um passo além: além de usar IA conversacional e aprendizado contínuo, costuma combinar essas capacidades com RPA (Robotic Process Automation) ou outras formas de automação para agir diretamente sobre os sistemas, executando tarefas em nome do usuário.

Uma forma intuitiva de enxergar isso é o exemplo da previsão do tempo:

- Com um chatbot tradicional, o usuário precisa dizer algo como “mostrar previsão do tempo”. O sistema responde: “vai chover amanhã”.

- Com um chatbot de IA, o usuário pode perguntar “como é que vai estar o tempo amanhã?” e o sistema continua respondendo corretamente que vai chover, mesmo com linguagem informal.

- Com um agente virtual, o usuário pergunta “como é que vai estar o tempo amanhã?” e, além de avisar que vai chover, o sistema oferece, por exemplo, ajustar o despertador mais cedo por causa do trânsito com chuva.

A tecnologia de base é em boa parte similar, mas o grau de autonomia e integração com outros sistemas é o que diferencia esses níveis.

Casos de uso: do termostato inteligente ao contact center

No lado do consumidor, chatbots de IA aparecem:

- dentro de apps de celular

- embutidos em dispositivos inteligentes, como termostatos, caixas de som, eletrodomésticos

- em sites de e-commerce, bancos, operadoras e serviços digitais em geral

No mundo corporativo, os usos se multiplicam:

- Marketing e vendas: personalizar experiências, tirar dúvidas sobre produtos, acompanhar carrinho de compras, qualificar leads, encaminhar para um vendedor humano quando necessário.

- TI e RH: permitir autoatendimento para funcionários (troca de senha, consulta de benefícios, status de chamados, políticas internas).

- Contact centers: servir como primeira linha de atendimento, filtrar demandas simples, direcionar casos complexos para humanos com contexto já carregado.

Chatbots com IA conversacional podem manter contexto ao longo da conversa e reutilizar esse histórico em interações futuras. Combinados com automação (incluindo RPA), permitem que o usuário realize tarefas relativamente complexas sem sair da interface de chat.

Quando a paciência do usuário acaba ou o problema é sensível demais, o sistema pode fazer uma transferência fluida para um atendente humano, enviando junto o histórico completo da conversa. Isso evita que a pessoa tenha que repetir tudo do zero.

E a interface pode ser texto ou voz. Em chamadas telefônicas, esses sistemas são conhecidos como IVR (Integrated Voice Response), mas cada vez mais se aproximam da mesma lógica usada nos chatbots de texto.

Principais benefícios: experiência melhor, custo menor

Quando um chatbot de IA funciona bem, os ganhos aparecem dos dois lados.

Engajamento e lealdade à marca

Antes dos chatbots, qualquer dúvida ou reclamação exigia um humano disponível, numa central de atendimento ou chat. Isso significa lidar com horários de pico, finais de semana, feriados, situações emergenciais fora do expediente.

Chatbots podem atender 24 horas por dia, 7 dias por semana, sem fila e para quantos usuários forem necessários ao mesmo tempo. Eles reduzem tempo de espera, dão respostas consistentes e liberam pessoas para lidarem com questões realmente complexas.

Um atendimento rápido, mesmo que automatizado, costuma ser melhor recebido do que longas filas e respostas atrasadas. Clientes bem atendidos, na média, tendem a manter uma relação mais duradoura com a marca.

Redução de custo e eficiência operacional

Manter um time grande disponível o tempo todo é caro. Treinar esse time para responder de forma alinhada também. A alternativa tradicional é terceirizar o atendimento para outro país ou empresa, o que traz custos próprios e perda de controle sobre a experiência do cliente.

Um chatbot bem implementado pode:

- assumir a primeira camada de atendimento

- absorver perguntas repetitivas

- aliviar o time humano em horários de pico ou madrugada

Com isso, a empresa ajusta melhor a escala da equipe humana, focando em interações de maior valor agregado.

Geração de leads e apoio à conversão

Em contextos de venda, o chatbot pode atuar como assistente comercial. Enquanto o usuário navega por produtos ou serviços, o sistema responde dúvidas específicas, compara planos, explica diferenças e orienta o próximo passo.

Em ofertas mais complexas, com vários estágios até o fechamento, o chatbot pode fazer perguntas de qualificação (tamanho da empresa, orçamento, urgência, necessidades específicas) e, quando faz sentido, conectar o usuário a um vendedor já munido dessas informações.

Limitações e riscos: onde o chatbot pode atrapalhar

Nenhuma dessas vantagens vem sem contrapartida. A forma como o chatbot é projetado, treinado e integrado faz toda a diferença.

Os modelos tradicionais, baseados em regras rígidas, são rápidos e previsíveis, mas limitados. Se o usuário sai do script, a conversa degringola. Isso pode gerar frustração e a sensação de que “o robô não entende nada”.

Já os chatbots com IA generativa trazem outros riscos:

- Segurança e privacidade: se informações sensíveis (dados de clientes, estratégias internas, documentos confidenciais) forem inseridas em um chatbot que treina seu modelo com tudo o que recebe, existe o risco de essas informações reaparecerem em respostas a outros usuários.

- Questões jurídicas e de propriedade intelectual: dependendo de como o modelo foi treinado e das licenças envolvidas, pode haver incertezas sobre uso de conteúdo, direitos autorais e responsabilidade por respostas incorretas.

- “Alucinações”: sem dados adequados ou sem limites claros, o modelo pode gerar respostas convincentes, porém erradas ou irrelevantes, obrigando o usuário a procurar outro canal e aumentando o desgaste.

Empresas precisam ter clareza sobre como o chatbot trata dados, se esses dados são usados para treinar modelos compartilhados com terceiros, se existe isolamento por cliente, quais políticas de retenção estão em vigor e como essas práticas se encaixam nas normas de segurança internas.

Como escolher um chatbot

Diante de tantas possibilidades, como decidir qual plataforma ou produto adotar? Algumas perguntas ajudam a organizar a decisão.

1. Qual problema precisa ser resolvido agora e qual poderá surgir depois?

É importante fugir da tentação de “ter um chatbot só porque todo mundo tem”. Começa-se perguntando:

- Por que este time quer um chatbot?

- Como essa necessidade está sendo atendida hoje?

- Onde estão os maiores atritos?

A partir daí, vale avaliar se a solução desejada:

- resolve bem esses objetivos imediatos;

- permite escalar e diversificar o uso no futuro, sem jogar tudo fora;

- oferece templates e componentes reaproveitáveis;

- tem modelo de preço compatível com a expansão interna.

2. Que impacto isso terá na experiência do cliente?

Chatbots são uma extensão da marca. Eles não representam apenas eficiência; representam um “jeito de falar” com o cliente.

O ideal é que:

- entendam o que o usuário quer, mesmo com linguagem informal

- respondam de maneira clara, não-robótica, alinhada ao tom da empresa

- evitem frases genéricas ou respostas desconectadas do contexto

Sem boas ferramentas de IA, o chatbot corre o risco de virar apenas uma FAQ glorificada, que irrita em vez de ajudar.

3. Quanto esforço será necessário para construir, treinar e melhorar?

Nem toda organização precisa da mesma profundidade técnica. Algumas querem algo pronto, com poucas customizações. Outras precisam de APIs ricas e liberdade para integrar com sistemas próprios.

Perguntas úteis:

- Que conteúdo virá pronto de fábrica?

- O que precisará ser criado internamente?

- É possível usar histórico de conversas e transcrições para treinar intenções e respostas, economizando tempo?

- O sistema oferece mecanismos de aprendizado contínuo, ajustando respostas com base em interações reais?

4. O chatbot se conecta ao que já existe ou tenta substituir tudo?

Novos canais raramente substituem completamente os antigos. No geral, viram mais um ponto de contato para gerenciar.

Um bom chatbot não rompe com os investimentos já feitos; ele:

- se conecta a sistemas de atendimento e bases internas

- conversa com canais existentes (site, app, telefone, redes sociais)

- direciona o usuário corretamente para pessoas ou fluxos quando necessário

A ideia não é apagar o que existe, mas amarrar os vários pontos em uma experiência mais contínua.

5. A solução atende aos requisitos de implantação, escala e segurança?

Cada setor tem suas próprias regras de compliance, privacidade e segurança. É importante ter isso claro desde o início.

Alguns pontos críticos:

- O chatbot é entregue em nuvem, on-premises ou há opção de ambiente dedicado?

- Os dados são usados para treinar modelos compartilhados ou permanecem isolados?

- O fornecedor atende aos requisitos específicos de setores regulados (como saúde, finanças, governo)?

- A solução escala bem com aumento de uso, sem degradação de desempenho?

Esses detalhes podem ser decisivos na hora de comparar fornecedores.

Um chatbot é menos sobre tecnologia e mais sobre como se quer conversar com pessoas em escala. Com as escolhas certas, ele vira uma peça central na estratégia de atendimento, marketing e operações, equilibrando automação com cuidado humano. Com as escolhas erradas, vira o robô que ninguém aguenta, aquele que todo mundo tenta driblar para conseguir falar com uma pessoa de verdade. O desafio está justamente em ficar do lado certo dessa linha.