Peças fundamentais de computação e criptografia quânticas precisam de fontes de fótons compactas, integráveis e, principalmente, controláveis. Não basta emitir luz: é preciso esculpir cada fóton, decidir para onde ele vai, como ele vibra e com que intensidade aparece. Parece pedir demais de um componente micrométrico? A equipe de Fei Ding, na Universidade do Sul da Dinamarca, resolveu encarar exatamente essa ambição: mostraram uma técnica que controla direção, polarização e intensidade ao mesmo tempo, a partir de uma única arquitetura em estado sólido.

A aposta não nasce do zero. O caminho passa por metassuperfícies (metasurfaces), camadas ultrafinas com nanoestruturas que convertem excitações de superfície em luz propagante. A novidade está na forma dos elementos que compõem essa camada e na maneira como essa geometria dá acesso independente aos “botões” da emissão. O resultado prático? Feixes únicos ou múltiplos, apontando para onde se deseja, com polarizações distintas (linear ou circular) e relações de intensidade programáveis, tudo saindo de uma plataforma que cabe em um chip.

Queremos tecnologias quânticas escaláveis, fabricáveis em série e que conversem com a microeletrônica atual. Isso exige fontes de fótons em estado sólido, nada de equipamentos volumosos de bancada para cada experimento. Para computação quântica fotônica e para redes quânticas, o fóton é o mensageiro de informação. Ter controle fino sobre direção (o para onde), polarização (a orientação do campo elétrico da onda) e perfil espacial (o desenho do feixe) é condição de contorno para qualquer arquitetura séria. Pergunta: sem esse controle, como acoplar luz a guias de onda, divisores, detectores e nós lógicos com eficiência e repetibilidade?

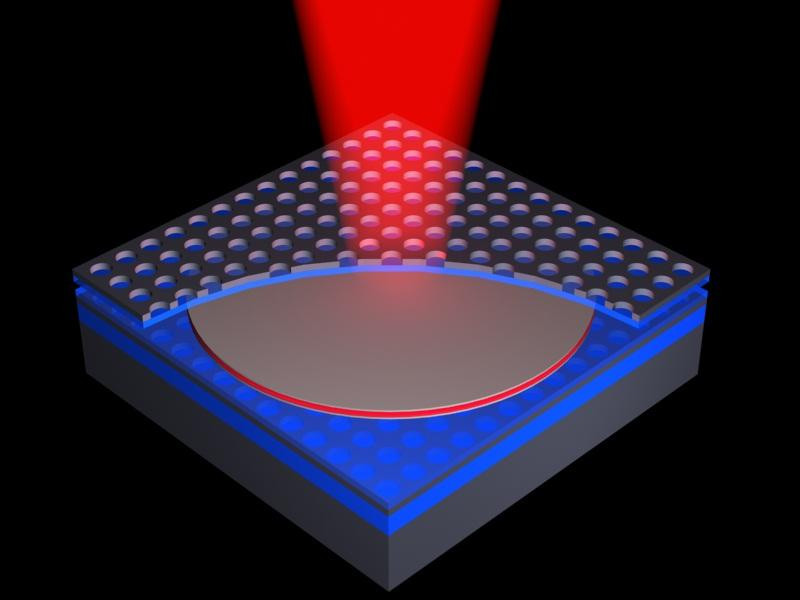

O dispositivo começa com um “sanduíche” meticulosamente montado: 30 nm de dióxido de silício sobre um espelho de prata de 150 nm. No topo, entra o emissor quântico, um nanodiamante com centros NV (nitrogênio emparelhado a lacunas de carbono), famoso por gerar fótons únicos quando excitado por laser. O pulso chega, o emissor responde e aciona polaritons plasmônicos de superfície (SPPs): ondulações híbridas que misturam campo eletromagnético com movimentos de carga ao longo do metal.

Essas ondas de superfície se espalham e encontram uma “clareira” desenhada com precisão: uma matriz de tiras de prata de 35 nm de espessura, espaçadas de 200 nm, que funcionam como nanoantenas. Cada tira intercepta a energia do SPP e a reradia como luz no espaço livre. Esse é o momento crucial: a forma e a orientação dessas nanoantenas definem como a energia vira fóton e que fóton sai.

Experimentos anteriores usavam elementos mais simétricos. O grupo escolheu retângulos. Por quê? Porque retângulos são anisotrópicos: apresentam respostas distintas conforme a direção do campo que chega. Essa assimetria dá uma alavanca extra, a possibilidade de controlar independentemente as fases das duas componentes de polarização circular (esquerda e direita) do fóton emitido. Traduzindo: quem controla a fase de cada componente circular controla a polarização final (linear, circular, elíptica) e o perfil espacial do feixe.

E não é só um feixe, a mesma estratégia programa vários feixes saindo simultaneamente, apontando para direções diferentes e exibindo polarizações distintas, com proporções de intensidade escolhidas no projeto. O arranjo completo tem cerca de 10 micrômetros de largura, dimensões plenamente compatíveis com rotas de integração em fotônica de silício e vizinhança.

Para garantir desempenho robusto, os pesquisadores organizaram as nanoantenas em geometrias como discos ou anéis (uma “rosquinha” micrométrica). O formato maior ajuda na estabilidade e no gerenciamento do acoplamento às ondas de superfície. Ainda assim, o tipo de polarização produzido não é ditado por esse contorno amplo; ele nasce da composição precisa das antenas retangulares lá dentro, a coreografia fina que decide se a luz sai linear, circular ou algo entre uma coisa e outra.

A peça-chave é a independência dos controles. A plataforma anterior já convertia SPPs em luz, mas faltava um painel que permitisse girar, separadamente, os botões de direção, polarização e intensidade e fazê-lo de forma generalizável. Agora há um framework único que gera:

um feixe único na direção desejada, com polarização definida com capricho,

ou múltiplos feixes em direções diferentes, com polarizações diferentes e razões de intensidade programadas,

sem abandonar a compacidade nem apelar para “gambiarras” fora do chip.

Quem trabalha com nanofotônica e com óptica integrada enxerga o valor imediato: há um caminho prático para rotear fótons como se fossem sinais elétricos, configurando portas, cruzamentos e multiplexadores com o grau de liberdade extra que a polarização oferece.

Por que isso importa para o mundo quântico? Computadores, sensores e links quânticos dependem de fótons solteiros com propriedades controladas. Em computação fotônica, a polarização pode codificar qubits; em comunicações, ela participa do entrelaçamento e de protocolos segurança-críticos. Direcionar emissão com precisão economiza perdas de acoplamento e melhora taxas de detecção, o que, na prática, significa menos erros e menos recursos para correção.

Quer um exemplo concreto? Projetar um chip que emita dois feixes correlacionados, cada um alimentando um circuito diferente, sem precisar mover a fonte, simplifica topologias de fontes entrelaçadas on-chip. Outro exemplo: escolher polarização circular específica para excitar modos quiralmente seletivos em guias ou cavidades. Quanto mais “dócil” for a fonte, mais elegante e compacto fica o desenho do restante do sistema.

Vale desacelerar um instante e olhar o mecanismo com lupa. O SPP traz fase e direção codificadas pelo emissor e pela metassuperfície. As nanoantenas retangulares “amostraram” essa onda e a espalharam como dipolos radiantes cuja fase relativa pode ser ajustada via posição, orientação e dimensões. Como a polarização circular pode ser decomposta em duas helicidades (esquerda e direita), manipular separadamente a fase de cada helicidade equivale a ter dois canais independentes que, recombinados, dão a polarização desejada. É uma espécie de sintetizador vetorial em escala nanométrica: componha dois vetores com fases e amplitudes que você escolhe e o resultado final aponta e gira como planejado.

Essa gramática geométrica também dita para onde a luz vai. Ao distribuir antenas com gradientes de fase impressos no espaço, criam-se padrões de interferência que “lançam” o feixe em ângulos específicos, uma antena phased-array em miniatura. O mesmo princípio, replicado em setores diferentes da estrutura, libera múltiplos feixes simultâneos.

Centros NV em diamante são veteranos da fotônica quântica: emitem fótons sob excitação por laser, toleram bem temperatura ambiente em certas aplicações e têm níveis de energia que permitem leitura óptica. Integrá-los a uma plataforma metal-dielétrica (prata e SiO₂) traz o melhor de dois mundos: um emissor quântico robusto e uma metassuperfície engenheirável. O “telefônico” dessa conversa é a eficiência com que o SPP vira fóton útil. Ali entram otimizações de espessuras, índices e distâncias para drenar o máximo de energia da onda de superfície para o feixe no espaço livre.

A mensagem se repete: controle total da emissão — direção, polarização e intensidade — não é capricho acadêmico; é pré-requisito para escalar tecnologias quânticas e nanofotônicas. Plataformas com um só grau de liberdade já provaram limite. É a combinação simultânea que muda o jogo de design.

Para quem desenha geradores, moduladores e gerenciadores de luz, a integração de fontes de fótons únicos dentro da metassuperfície é uma ponte curta entre laboratório e dispositivos reais. O trabalho atual faz eco a anos de pesquisa em metasuperfícies, mas troca a luz clássica por fontes quânticas e amplia o leque de controle de forma paramétrica. A leitura otimista é direta: ficou mais fácil planejar fontes sob medida para arquiteturas fotônicas específicas, sem reescrever todo o processo a cada novo requisito.

Próximo passo sensato: emissão elétrica on-chip. Bombear com laser funciona para prova de conceito e medições. Para escala industrial, o ideal é bombear eletricamente o emissor quântico, tal como fazemos com LEDs e lasers de diodo. A própria equipe mira integrar essa plataforma a emissores acionados por corrente, reduzindo complexidade de ótica externa e aproximando o componente do ecossistema de circuitos integrados. Faz sentido: quem quer uma fábrica inteira de lasers apenas para alimentar cada fonte em um chip?

A trajetória recente da fotônica quântica sugere que os blocos-de-montar certos — emissores quânticos estáveis, metassuperfícies projetáveis, antenas nanoestruturadas — estão convergindo para bibliotecas de projeto. A contribuição aqui é uma biblioteca mais expressiva: com as mesmas peças, é possível escrever “frases” óticas diferentes, isto é, feixes com direções, polarizações e intensidades escolhidas à vontade.

Pergunta final, que vale tanto para quem pesquisa quanto para quem pretende usar: que aplicações ganham vantagem imediata com um “sintetizador de fótons” on-chip? Candidatos naturais aparecem: chaves e roteadores quânticos em redes metropolitanas, fonte dual de fótons para protocolos de teste de Bell integrados, interfaces quiralmente seletivas para acoplar fótons a qubits de matéria. Quando a fonte passa a obedecer ao projeto, o resto do circuito agradece.

Transformar a ondulação de superfície de um metal em feixes sob encomenda era uma ideia elegante; transformá-la em uma caixa de ferramentas com três botões independentes — direção, polarização, intensidade — aproxima a fotônica quântica do tipo de engenharia modular que fez a microeletrônica decolar. O chip ainda é pequeno.

Referência:

On-Chip Emitter-Coupled Meta-Optics for Versatile Photon Sources - Controlar a emissão espontânea de emissores quânticos (EQs) em nanoescala é crucial para o desenvolvimento de fontes avançadas de fótons, necessárias em muitas áreas da nanofotônica moderna, incluindo tecnologias de informação quântica. Abordagens convencionais para moldar a emissão de fótons baseiam-se no uso de configurações volumosas, enquanto abordagens recentemente desenvolvidas em metafotônica quântica sofrem de capacidades limitadas para atingir estados de polarização e direcionalidade desejados, falhando em fornecer fontes de fótons sob demanda adaptadas precisamente às necessidades tecnológicas. https://journals.aps.org/prl/abstract/10.1103/klq1-wjjg