GPUs, muito além de jogos

E se a lâmpada do seu quarto não servisse só para iluminar, mas também para mandar internet para o seu notebook e, de quebra, alimentar pequenos sensores espalhados pela casa? Para um grupo de pesquisadores da Universidade de Oulu, na Finlândia, essa ideia não é ficção científica: é um possível próximo passo para o jeito como usamos o próprio conceito de “luz artificial”.

O ponto de partida é simples e, ao mesmo tempo, bem provocador: tratar a iluminação que já existe em casas, escritórios, hospitais e fábricas como uma espécie de “super infraestrutura” universal. Em vez de apenas acender o ambiente, essas luzes poderiam transmitir dados e fornecer energia para dispositivos compactos. Esse é o foco do projeto SUPERIOT, liderado pelo pesquisador Marcos Katz, que estuda tecnologias de comunicação de próxima geração e tenta reaproveitar o que já está espalhado pelas cidades de um jeito novo.

Quem vive em áreas urbanas praticamente não escapa da luz artificial. Ela está nas luminárias da sala, nos escritórios com telhas de gesso e lâmpadas embutidas, nos corredores de hospitais, nos galpões industriais. Os pesquisadores lembram que, até a metade da próxima década, a maior parte dessa iluminação interna deve ser feita com LEDs brancos, que são fáceis de controlar eletronicamente e conseguem mudar de intensidade muito rápido.

Esse detalhe técnico abre uma porta interessante. Um LED consegue piscar em velocidades tão altas que o olho humano enxerga um brilho estável, contínuo. Mas, para um sensor, essas microvariações podem ser lidas como zeros e uns, ou seja, como informação. A ideia central do projeto é justamente explorar isso: usar a mesma energia elétrica que alimenta a lâmpada para criar um canal de comunicação de alta velocidade.

Em vez de apenas iluminar a mesa, o teto do escritório vira um grande “roteador” de luz. À primeira vista, parece estranho pensar em internet vinda da lâmpada, mas o princípio é parecido com o do Wi-Fi, só que usando luz visível no lugar de ondas de rádio.

A equipe de Katz trabalha com o que se chama de comunicação por luz visível. Em vez de antenas emitindo rádio, o papel de transmissor fica com a própria lâmpada de LED. Ela faz mudanças muito rápidas na intensidade da luz, imperceptíveis para quem está no ambiente, mas claras para um receptor, como o sensor de um smartphone ou de um notebook.

Do ponto de vista do usuário, a experiência é banal: o ambiente continua iluminado, nenhum brilho estranho aparece. Mas, por trás disso, o aparelho traduz essas variações em fluxo de dados — páginas da web, vídeos, mensagens. Para a transmissão no sentido contrário, do dispositivo para a infraestrutura, os pesquisadores estudam o uso de comprimentos de onda invisíveis, como o infravermelho. Assim, não surgem flashes incômodos na tela ou no próprio aparelho.

Um jeito de visualizar é imaginar a lâmpada como alguém falando muito rápido em código Morse, só que num ritmo tão acelerado que você só vê uma luz constante. O computador, por outro lado, “escuta” cada pequeno pulso.

Por que se dar ao trabalho, se o Wi-Fi já resolve tanta coisa? Os cientistas apontam situações em que ondas de rádio podem ser problemáticas: ambientes cheios de equipamentos sensíveis, como hospitais, plantas industriais e até cabines de avião. Nesses contextos, a luz pode oferecer um caminho paralelo para transmissão de dados, evitando interferências indesejadas.

Há também um aspecto de confidencialidade. O feixe de luz não atravessa paredes como um sinal de rádio. Para interceptar a comunicação, seria preciso estar dentro do espaço iluminado, sob a mesma lâmpada. Isso reduz a área de exposição do sinal e pode tornar certos tipos de acesso não autorizado bem mais difíceis.

Essa característica levanta uma pergunta interessante: e se parte da segurança digital do futuro vier, literalmente, da maneira como um cômodo é iluminado?

Esse cenário promissor não vem sem obstáculos. Para começar, transmissor e receptor precisam “se enxergar”. Se algo cobre o sensor do celular ou se o aparelho é colocado numa posição em que não recebe diretamente a luz, a qualidade da conexão cai ou some de vez. Nesse ponto, o dispositivo volta automaticamente para o canal tradicional de rádio, como Wi-Fi ou 4G/5G.

Outra limitação é mais óbvia: sem luz artificial, não há canal de dados. Em ambientes que dependem majoritariamente de iluminação natural, como áreas externas durante o dia, essa forma de comunicação perde sentido. A tecnologia, então, se encaixa melhor em contextos controlados, fechados, onde a iluminação já é, de qualquer forma, indispensável.

Esse equilíbrio entre vantagens e restrições faz parte da própria natureza da proposta: não se trata de substituir tudo o que existe, mas de somar mais uma camada às redes de comunicação.

O projeto SUPERIOT não se limita à transmissão de dados. Os pesquisadores querem explorar também o papel da iluminação como fonte de energia para pequenos dispositivos. Em visões de “cidades do futuro”, imagina-se um número crescente de sensores espalhados pelos ambientes, coletando dados sobre temperatura, qualidade do ar, ocupação de salas, entre outros pontos, sem exigir manutenção constante.

Para alimentar esses sensores, entram em cena minúsculas células solares capazes de aproveitar a própria luz do ambiente, não só a luz do sol que entra pela janela. Em vez de pilhas e baterias que precisam ser trocadas e geram descarte, os dispositivos podem funcionar com a energia que já está sendo gasta para iluminar o local.

Ao mesmo tempo, o grupo trabalha com eletrônica impressa: componentes feitos em superfícies finas, como se fossem etiquetas, e produzidos por processos parecidos com impressão. A ideia é diminuir o uso de materiais raros e caminhar para dispositivos tão discretos que cabem numa lâmina do tamanho de um cartão de banco.

Essas “etiquetas eletrônicas” podem atuar como sensores em diferentes cenários. Dentro de um prédio, por exemplo, elas monitoram umidade e temperatura de salas, ajudando a ajustar automaticamente a ventilação ou o ar-condicionado. Em embalagens de alimentos, podem atualizar dados sobre o estado do produto em tempo quase real.

Na área da saúde, protótipos de sensores impressos já são pensados para tarefas como rastrear a localização de equipamentos hospitalares, registrar deslocamentos de equipes e acompanhar o estado de pacientes. Em situações críticas, um sensor colado na roupa ou na cama poderia enviar um alerta imediato se detectar uma queda ou uma mudança brusca de temperatura corporal.

Tudo isso parte da mesma lógica: aproveitar o que já existe — a luz do ambiente, as superfícies disponíveis, a infraestrutura atual — para distribuir inteligência e conectividade de forma mais discreta e menos dependente de grandes intervenções físicas.

Ao olhar para lâmpadas como potenciais pontos de acesso à rede e fontes de energia para dispositivos minúsculos, os pesquisadores de Oulu convidam a repensar o que entendemos como “infraestrutura”. A mesma luz que hoje só acende o corredor pode, num cenário próximo, transportar dados e alimentar sensores quase invisíveis.

Essa visão não elimina a necessidade de outras tecnologias, nem resolve todos os problemas de conectividade e sustentabilidade de uma vez. Ela aponta, porém, para um caminho de uso mais esperto do que já está aí: menos cabos novos, menos baterias descartadas, mais funções concentradas em elementos cotidianos. A questão que fica é como equilibrar essas possibilidades com as limitações físicas e práticas, para que o futuro “iluminado” da internet das coisas seja não só tecnicamente engenhoso, mas também sensato e bem pensado.

Referências:

The future LED light both illuminates and communicates - https://www.oulu.fi/en/news/future-led-light-both-illuminates-and-communicates

SUPERIOT-Truly Sustainable Printed Electronics-based IoT Combining Optical and Radio Wireless Technologies - https://superiot.eu/

Há quem imagine que programar exige um talento inato, uma espécie de vocação misteriosa, como de matemática e reservada a poucas pessoas. Esse mito persiste na maioria, embora a realidade seja mais generosa, programar é uma habilidade ensinável, incremental, e profundamente útil para a vida prática. Entre as linguagens disponíveis, Python se destaca pela clareza, pela comunidade vibrante e pela vasta coleção de bibliotecas que resolvem problemas reais. Este texto propõe um passeio reflexivo e didático sobre o que é Python, por que ele é considerado simples, e como se pode aplicá-lo em tarefas do dia a dia.

Python foi desenhado com uma preocupação central, legibilidade. O código se parece com uma sequência de instruções em língua natural, com vírgulas, nomes descritivos e blocos bem demarcados por indentação. Isso convida o iniciante em programação a entender o que está acontecendo, sem ruídos visuais. Outra vantagem está na filosofia da linguagem, há um modo óbvio de fazer as coisas, o que reduz o dilema de escolhas entre dezenas de sintaxes diferentes. Sendo uma vantagem grande é a linguagem ser interpretada, o que permite experimentar ideias em pequenos passos, corrigir erros com rapidez e aprender por tentativa, erro e observação, um ciclo muito natural para quem está começando.

Aprender é mais confortável quando se encontra acolhimento, Python oferece isso de várias formas. Existem ambientes como o Jupyter Notebook, um programa de computador que sever como um caderno de notas, muito poderoso, permitindo escrever trechos de código, executar, ver o resultado, e registrar comentários. Existem muitas comunidades em português, guias introdutórios, fóruns e cursos gratuitos. A instalação é simples, basta baixar um pacote oficial e, quando surgir a curiosidade por bibliotecas adicionais, um gerenciador de pacotes, chamado PIP, resolve a maior parte das necessidades com um único comando. Essa combinação de ferramentas e pessoas forma um ecossistema onde dúvidas encontram respostas, e onde exemplos prontos aceleram a prática.

Uma das coisas mais interessante que programar em Python faz, é educar no pensamento computacional, que nada mais é que aprender a decompor problemas em etapas claras, identificar padrões, criar regras e testar hipóteses. Esse tipo de pensamento serve para além do computador, auxilia na organização de tarefas, na tomada de decisões e na análise de dados pessoais. Ao encarar uma lista de contas, um conjunto de mensagens ou um histórico de gastos, a pessoa passa a perguntar, como posso estruturar essa informação, que padrões existem aqui, que perguntas posso responder. Python vira um caderno de laboratório, onde experiências são registradas e reproduzidas.

Considere uma tarefa comum, renomear dezenas de arquivos de fotos para um padrão de data, ou separar documentos por tipo. Manualmente, isso consome tempo e atenção e com Python, um pequeno script percorre uma pasta, identifica as extensões, extrai a data e renomeia cada arquivo de maneira consistente. O ganho não é somente a economia de minutos, é a criação de um procedimento confiável, repetível, que reduz erros. Essa ideia se estende a outros cenários, converter planilhas em formatos diferentes, extrair uma lista de contatos de um arquivo de texto, dividir um conjunto grande de PDFs por capítulos, tudo se torna viável com poucas linhas e muita clareza.

A vida digital produz dados em excesso, extratos bancários em CSV, relatórios em PDF, planilhas com colunas confusas e Python oferece bibliotecas como para ler, limpar e analisar essas informações. Imagine o controle do orçamento doméstico, é possível ler automaticamente cada extrato, categorizar despesas por supermercado, transporte, moradia, calcular médias, somas e variações, e gerar um resumo mensal. Em vez de contar com planilhas feitas às pressas, o processo se torna uma rotina reprodutível, onde o código documenta o método. O resultado, além de números, é compreensão, uma visão detalhada dos hábitos de consumo que orienta decisões mais conscientes.

Muitas perguntas se resolvem com estatística básica. Quantas horas de sono por semana, qual o horário de pico de mensagens no celular, qual a frequência do uso do aplicativo de transporte. Python calcula médias, medianas, contagens e desvios com facilidade, e ainda produz gráficos simples que comunicam padrões. Ao visualizar o histórico de passos em um gráfico de linhas, ou a distribuição de gastos em um gráfico de barras, a mente percebe tendências que passariam despercebidas em uma tabela. Essa alfabetização visual, possibilitada pelas bibliotecas de visualização, traduz números em histórias compreensíveis.

Muitos desejam iniciar um hábito e manter constância, Python pode funcionar como um assistente de registro. Um arquivo de texto com datas e atividades, lido por um script, vira um painel semanal, mostrando dias em que o hábito foi cumprido, lacunas e progressos. Isso vale para leitura, prática de exercícios, estudo de línguas, meditação. A programação permite transformar anotações simples em indicadores úteis. Em termos educacionais, o benefício é duplo, a pessoa aprende a programar enquanto acompanha a própria evolução em qualquer objetivo que valorize.

Sites públicos divulgam informações de clima, transporte, notícias e preços e Python consegue consultar essas fontes com requisições HTTP, respeitando termos de uso, limites e políticas de privacidade. Com isso, torna-se possível, por exemplo, montar um alerta para a previsão de chuva no bairro, ou comparar automaticamente os preços de um produto em três lojas, evitando compras impulsivas. Em tempos de dados abundantes, aprender a coletar somente o necessário, com consentimento e responsabilidade, é parte da formação científica. O código documenta a origem da informação, o horário da coleta e o método aplicado, o que fortalece a transparência.

Grande parte do que fazemos envolve texto, mensagens, e mails, anotações e Python oferece ferramentas de processamento de linguagem natural que vão do simples ao sofisticado. Sem complicar, é possível limpar acentos, contar palavras, extrair datas e valores, e organizar tudo em uma planilha. Um caso comum é o acompanhamento de confirmações de compra recebidas por e mail, o código lê a pasta apropriada, extrai o valor, a loja e a data, e gera um resumo mensal. Esse processo não é espionagem, é automação do que já pertence à própria pessoa, com consentimento explícito, e com foco em organização e controle.

Embora aplicativos de agenda resolvam muita coisa, Python permite criar lembretes sob medida. Imagine uma lista de tarefas que depende de eventos externos, como pagar uma conta sempre que o saldo cair abaixo de um valor, ou revisar um documento dois dias após recebê lo. Um script simples verifica condições, lê datas e envia notificações por meio de mensagens ou e mails. O personalizado faz diferença, pois cada pessoa organiza a vida de um jeito, e a programação permite adaptar a lógica para cada caso. O resultado é menos esquecimento e mais regularidade, com baixo esforço manual.

Mesmo para quem não pretende trabalhar como desenvolvedor, Python amplia horizontes profissionais. Em áreas como marketing, jornalismo, saúde e administração, a capacidade de automatizar tarefas e analisar dados aprimora a produtividade. Um jornalista pode cruzar bases públicas e encontrar histórias que os olhos não percebem em planilhas extensas, ou um profissional de saúde pode organizar registros de atendimentos e observar padrões de demanda, ou até mesmo um administrador pode simular cenários de custos e receitas com clareza. Em todos os casos, Python funciona como um instrumento, assim como uma planilha ou um editor de texto, com a vantagem da repetibilidade e da precisão.

Aprender Python é muito simples, o progresso se sustenta com pequenos estudos, vinte ou trinta minutos por dia, resolvendo problemas reais e registrando o que deu certo. O iniciante pode começar com operações básicas, somar, subtrair, manipular textos, depois listas e dicionários, mais adiante leitura e escrita de arquivos. Para aprender com eficiência está na prática, na curiosidade em transformar uma tarefa chata em um pequeno programa. Quando surge uma dúvida, a comunidade tem respostas, e o próprio erro vira material de estudo. A linguagem incentiva esse caminho, pois fornece feedback rápido e mensagens de erro compreensíveis.

Como em qualquer ofício, hábitos saudáveis evitam dores futuras. Em Python, vale dar nomes claros a variáveis e funções, escrever comentários curtos onde o raciocínio pode confundir, dividir o programa em partes pequenas e testáveis. É interessante aprender a lidar com erros de forma simples, informando o que aconteceu e oferecendo sugestões de correção. Em projetos pessoais, manter os arquivos organizados e versionados, com histórico de alterações, facilita retomar trabalhos antigos. Esses cuidados não exigem sofisticação, apenas atenção, e a recompensa é grande quando os projetos crescem ou quando outra pessoa precisa entender o que foi feito.

Para tornar tudo mais palpável, convém visualizar algumas aplicações simples. Ao planejar o cardápio da semana, um pequeno programa cruza receitas com o estoque da despensa, calcula quantidades e produz a lista de compras, evitando desperdício. Ao acompanhar viagens diárias, outro script lê registros de ônibus ou transporte por aplicativo, calcula tempos médios e sugere o melhor horário de saída para reduzir atrasos. No controle de gastos, como já mencionado, um conjunto de funções importa extratos, classifica despesas e mostra um resumo amigável, com categorias e tendências. Em casa, a organização de fotos e documentos fica mais fácil com renomeações consistentes, que preservam a data e o assunto, já nos estudos, um programa faz revisões espaçadas, apresentando questões em intervalos crescentes, de acordo com a memória de cada pessoa. Todas essas ideias cabem em poucas dezenas de linhas e entregam valor direto.

O poder de Python cresce com as bibliotecas e existem módulos para lidar com datas, tempo e fusos horários, o que evita erros ao comparar eventos. Muitas ferramentas para lidar com números e matrizes, úteis na análise de dados e no processamento de imagens. Para quem trabalha com planilhas, existem pacotes que leem e escrevem arquivos do Excel com precisão. Para quem precisa se comunicar com serviços externos, há clientes para APIs populares, o que permite integrar calendários, listas de tarefas e serviços de armazenamento. A sensação é a de construir com peças, como um jogo de montar, onde as conexões são claras e a montagem é guiada pela necessidade.

Escrever sobre o que se fez consolida a aprendizagem e ao terminar um pequeno projeto, vale registrar o objetivo, os dados usados, o método, os resultados e as limitações. O próprio arquivo de código pode conter essa narrativa, em comentários e anotações. Essa prática ajuda no futuro, quando surgir a pergunta, por que escolhi esse caminho, como reproduzo esse resultado, o que posso melhorar. Para a pessoa leiga, o hábito de documentar reduz a ansiedade, pois coloca ordem na experiência e cria um histórico de evolução. Python favorece isso porque muitas ferramentas, como os notebooks, misturam texto, código e resultado no mesmo lugar.

Ao executar um programa, eventualmente algo não funciona, um arquivo não é encontrado, uma conversão falha, uma conta sair diferente do esperado. Longe de intimidar, esses erros oferecem pistas valiosas e as mensagens explicam o que ocorreu e apontam a linha onde o problema surgiu. O iniciante aprende a ler essas pistas, a procurar causas prováveis e a testar hipóteses e com o tempo, surge a confiança para lidar com o imprevisto, o que transborda para outras áreas da vida. Python não pune o erro, ele informa e convida à correção, o que cria um ambiente de aprendizado seguro e produtivo.

Outra barreira imaginária está no equipamento e para aprender Python, um computador modesto atende bem, desde que suporte um editor de texto e a execução de programas simples. Não há necessidade de placas de vídeo caras ou servidores específicos. Isso democratiza o acesso e amplia as oportunidades. Para a maioria das aplicações cotidianas, o que conta é a clareza do raciocínio e a organização dos dados. Essa realidade encoraja estudantes, profissionais em transição e curiosos de todas as idades a experimentar, sem medo de investimento alto.

À medida que a confiança aumenta, surgem interesses novos. Algumas pessoas desejarão explorar visualizações interativas e painéis, outras preferirão análise de dados mais robusta, outras ainda se encantarão por automações de e mail, agendas e mensagens. Python acompanha esses passos com naturalidade. Existem caminhos para ciência de dados, com técnicas de aprendizado de máquina, há rotas para desenvolvimento web, com frameworks que constroem sites e serviços, há trilhas para computação científica, com simulações e modelos. O importante é reconhecer que a base é a mesma, variáveis, estruturas, funções e bibliotecas, e que o aprofundamento pode ser gradual, guiado por problemas reais.

Ao final desta reflexão, fica uma ideia central, Python é menos sobre tecnologia e mais sobre método. Ele ensina a observar, formular perguntas, estruturar dados e testar respostas. Ao aplicar a linguagem no cotidiano, a pessoa desenvolve autonomia, ganha tempo, organiza a informação e melhora a qualidade das decisões. O caminho não requer genialidade, requer somente paciência, curiosidade e pequenos passos consistentes. Para começar, vale escolher um problema concreto, algo que incomoda ou toma tempo, e perguntar, como transformo isso em uma sequência clara de instruções. Escrever, executar, corrigir e repetir, essa é a rotina. Em pouco tempo, o que era nebuloso se torna claro, e a linguagem passa a ser uma ferramenta confiável, uma extensão do pensamento. Python, com sua simplicidade e potência, está ao alcance de qualquer pessoa disposta a experimentar, e seu impacto se revela no lugar mais importante, na vida real, onde as pequenas melhorias somadas produzem grandes resultados.

Provavelmente você está lendo este texto em um computador, um tablet ou um smartphone, certo? Vale a pena voltar no tempo para entender como chegamos aqui. Em 1981, a IBM lançou o PC modelo 5150. Ele não foi o primeiro computador pessoal, porém se tornou o mais influente por definir padrões de hardware e software que reorganizaram um mercado fragmentado. Nesta leitura didática, você vai ver por que aquela máquina, que hoje parece um trambolho, virou a base da era digital.

No início dos anos 1980, existiam ótimos micros, como Apple II, TRS-80 e Commodore PET. Cada um era um universo próprio, com sistema, periféricos e programas específicos. Um software comprado para Apple II não funcionava no TRS-80, e assim por diante. Desenvolvedores precisavam portar versões diferentes do mesmo programa, usuários ficavam presos ao ecossistema escolhido, empresas hesitavam em adotar em larga escala. Nesse cenário, a IBM, gigante dos mainframes, observava à distância, perdendo espaço para minicomputadores e para os novos microcomputadores. O mercado de PCs já crescia mais de 40% ao ano, movendo bilhões de dólares. Ignorar deixou de ser opção.

Ainda em 1980, a diretoria incumbiu uma equipe de criar um PC para consumidores em cerca de um ano, algo impensável para a cultura tradicional da empresa. A equipe adotou decisões radicais para ganhar velocidade, como utilizar componentes prontos do mercado e, principalmente, definir uma arquitetura aberta. Em 12 de agosto de 1981, no Hotel Waldorf Astoria, em Nova York, o IBM PC 5150 foi apresentado. O preço de entrada variava conforme a configuração, posicionando a máquina para escritórios e entusiastas.

CPU: Intel 8088 a 4,77 MHz. Ele era mais barato e disponível do que alternativas, e mantinha compatibilidade com a família 8086, o que favorecia a adoção.

Memória: 16 KB no básico, expansível, chegando a 640 KB com placas e bancos adicionais.

Armazenamento: versões sem disco, com interface para gravador de fitas; na prática, quase todos vinham com uma ou duas unidades de disquete de 5¼", com 160 KB ou 320 KB.

Vídeo: saída textual monocromática em monitores como o MDA, medido em caracteres em vez de pixels nas configurações de texto; opções gráficas surgiram via placas.

Expansão: cinco slots ISA. Este foi um divisor de águas, pois permitia adicionar placas de vídeo, som, portas, memória e até discos rígidos.

O mais importante do que a lista técnica foi a estratégia: a IBM publicou documentação detalhada do hardware e do BIOS, estimulando terceiros a criar periféricos e software. Essa abertura acelerou a formação de um ecossistema vibrante.

Ao optar pela arquitetura x86 da Intel, a IBM semeou o padrão que dominaria PCs por décadas. Para o sistema operacional, a empresa tentou negociar com o fornecedor do popular CP/M, porém o acordo não prosperou. A IBM então fechou com a Microsoft, que licenciou um sistema chamado 86-DOS, renomeado como MS-DOS. Um ponto estratégico ocorreu aqui: a Microsoft manteve o direito de licenciar o MS-DOS a outros fabricantes, o que permitiu que o sistema se tornasse padrão da indústria e preparou o terreno para o Windows, que mais tarde viria com interface gráfica. Essa combinação x86 + MS-DOS criou uma base comum para fabricantes, desenvolvedores e usuários.

A publicação do design e do BIOS, somada à estrutura modular, abriu espaço para a engenharia reversa legal do BIOS por terceiros e para o surgimento dos clones compatíveis com IBM. Empresas como Compaq, Dell e outras produziram PCs mais baratos e acessíveis, mantendo compatibilidade com o software do ecossistema IBM. O efeito foi duplo, para a sociedade, houve queda de preços e padronização, democratizando a computação em casas e escritórios. Conforme a IBM, a consequência foi a perda gradual do controle sobre o padrão que ela mesma criou.

A marca IBM transmitia confiança ao mercado corporativo. Sua entrada validou o PC como ferramenta séria de trabalho. Em 1983, o lançamento da planilha Lotus 1-2-3 tirou proveito do hardware do PC e virou o primeiro “killer app”, impulsionando vendas no mundo corporativo, pois resolvia um problema de negócios com ganho claro de produtividade. Software útil, padrão aberto e marca confiável criaram um ciclo virtuoso de adoção.

Evolução rápida: XT, AT e o tropeço do Micro Channel

IBM PC XT (1983): trouxe disco rígido interno de 10 a 20 MB e mais expansão, reduzindo a dependência de disquetes e melhorando fluxos de trabalho.

IBM PC AT (1984): adotou o processador Intel 80286 e barramento de 16 bits, oferecendo de três a seis vezes mais desempenho e ampliando a capacidade do sistema.

PS/2 e MCA (1987): tentando retomar o controle do padrão, a IBM lançou a arquitetura Micro Channel (MCA), tecnicamente superior ao ISA, porém proprietária e cara de licenciar. O mercado, já habituado à abertura, reagiu com o EISA, mantendo compatibilidade e filosofia aberta. O resultado consolidou o padrão aberto fora do domínio direto da IBM.

O PC transformou a cultura popular e o trabalho. E já em 1982, a revista Time nomeou o computador pessoal como “Máquina do Ano”, evidenciando o impacto social. A IBM veiculou campanhas com o personagem de Chaplin para humanizar a tecnologia, aproximando-a do “cidadão comum”. Somando a queda de preço padrão estável e aplicações úteis levou a computação pessoal a escritórios, escolas e casas, impulsionando comunicação, produtividade e educação.

Com o tempo, o mercado de PCs se comoditizou. Com margens ficaram menores, a diferenciação migrou para camadas de software, serviços e integração. Em 2005, a IBM vendeu sua divisão de PCs para a Lenovo, por entender que seu foco estratégico deveria ser consultoria, software corporativo e infraestrutura de alto valor. É um paradoxo interessante, a empresa que catalisou a era do PC acabou deixando esse mercado para priorizar áreas mais alinhadas à sua estratégia de longo prazo.

Padronização de hardware: a arquitetura x86 e o barramento de expansão criaram uma base comum para inovação incremental.

Abertura documentada: a publicação do hardware e do BIOS fomentou um ecossistema amplo de periféricos e software.

Decisões de licenciamento: o modelo da Microsoft para o MS-DOS permitiu a adoção transversal por múltiplos fabricantes.

Ecossistema de aplicações: com destaque para a planilha, que justificou a compra e consolidou o PC como ferramenta de negócios.

Efeito rede: mais PCs significaram mais desenvolvedores, o que gerou mais programas, incentivando mais compras, em um círculo virtuoso.

Arquiteturas abertas aceleram mercados, ainda que reduzam o controle do originador. A IBM catalisou um padrão ao qual ela própria não conseguiu impor regras proprietárias depois.

Licenciamento inteligente cria plataformas: Ao não reter exclusividade do MS-DOS, a Microsoft semeou a onipresença do seu software, o que mais tarde favoreceria o Windows.

Killer apps mudam o jogo. Hardware sem casos de uso claros não escala: A planilha alterou a curva de adoção empresarial.

Tempo de mercado importa: Um produto “bom o bastante” entregue rápido, com documentação e parceiros, vence soluções isoladas e incompatíveis.

Comoditização é inevitável: Diferenciação migra para serviços, integração e experiência, exigindo ajustes estratégicos conforme o ciclo de vida da tecnologia.

O IBM PC não foi o primeiro computador pessoal, porém foi o catalisador que transformou um mosaico incompatível em um padrão global. Suas escolhas de design, a arquitetura aberta, o uso de componentes prontos e a parceria com a Microsoft criaram uma plataforma que moldou a computação pessoal moderna. Até hoje, muito do que usamos carrega o DNA daquela máquina de 1981, lembrando que decisões estratégicas, mesmo com efeitos colaterais inesperados, podem moldar indústrias inteiras e a nossa relação com a tecnologia.

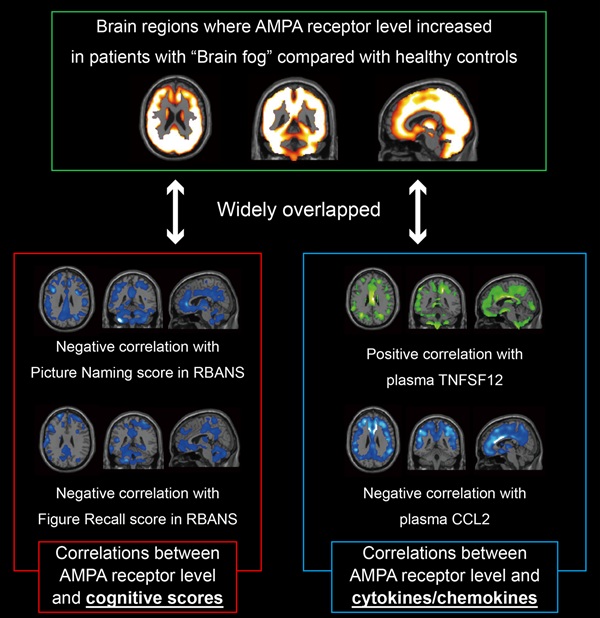

A COVID longa é uma condição crônica que provoca problemas cognitivos conhecidos como névoa mental, porém seus mecanismos biológicos seguem em grande parte obscuros. Agora, em uma pesquisa conduzida no Japão, utilizou uma técnica de imagem inédita para visualizar receptores AMPA, moléculas centrais para memória e aprendizagem, no cérebro vivo. O trabalho mostrou que uma maior densidade desses receptores em pessoas com COVID longa está ligada à gravidade dos sintomas, o que coloca essas moléculas no foco como possíveis biomarcadores diagnósticos e alvos terapêuticos.

Mesmo passados anos desde o início da pandemia de COVID-19, os efeitos da infecção pelo SARS-CoV-2 não estão totalmente esclarecidos. Isso é especialmente verdadeiro para a COVID longa, um quadro que pode surgir após a fase aguda e que reúne sintomas persistentes. Entre os mais comuns e incapacitantes está a disfunção cognitiva, muitas vezes chamada de névoa mental, que atinge mais de oitenta por cento das pessoas com esse diagnóstico. Diante de centenas de milhões de casos no mundo, a COVID longa representa um grande desafio na saúde pública e na economia, porque compromete a capacidade de trabalhar e realizar atividades diárias.

Apesar de sua prevalência, as causas subjacentes da COVID longa e da névoa mental permanecem difíceis de definir. Estudos de imagem apontaram alterações estruturais no cérebro, mas não identificaram as disfunções moleculares diretamente responsáveis pelos sintomas. Observar as moléculas que regem a comunicação entre neurônios é tarefa complexa, por isso faltavam biomarcadores objetivos para confirmar o diagnóstico ou para orientar terapias alinhadas a mecanismos.

Para enfrentar essa lacuna, a pesquisa partiu da hipótese de que haveria expressão alterada de receptores AMPA, elementos essenciais para a plasticidade sináptica, a memória e a aprendizagem, hipótese apoiada por achados em transtornos psiquiátricos e neurológicos. Com isso, foi aplicada uma metodologia de PET com traçador [11C]K-2 voltada a receptores AMPA, capaz de visualizar e quantificar a densidade desses sítios no cérebro humano, oferecendo uma janela direta para a bioquímica das sinapses.

Comparando dados de trinta pessoas com COVID longa a oitenta indivíduos saudáveis, a pesquisa encontrou um aumento notável e disseminado na densidade de receptores em diferentes regiões cerebrais do grupo afetado. Essa elevação correlacionou-se de forma direta com a gravidade do prejuízo cognitivo, sugerindo um elo claro entre a alteração molecular e os sintomas relatados. Além disso, concentrações de marcadores inflamatórios também se correlacionaram com os níveis dos receptores, sinalizando uma possível interação entre inflamação e expressão sináptica.

Tomados em conjunto, os achados representam um passo decisivo para questões ainda em aberto sobre a COVID longa. O aumento sistêmico de receptores AMPA fornece uma explicação biológica para a névoa mental e aponta um alvo concreto para intervenções. Fármacos que atenuem a atividade desses receptores despontam como abordagem plausível para mitigar o quadro cognitivo, hipótese que precisa ser testada com desenho clínico rigoroso e monitoramento de segurança. A análise também mostrou que os dados de imagem distinguem pacientes e controles com cem por cento de sensibilidade e noventa e um por cento de especificidade.

Embora sejam necessários novos esforços para chegar a soluções definitivas, o trabalho indica uma direção promissora. Reconhecer a névoa mental como condição clínica legítima ajuda a organizar linhas de cuidado, a planejar protocolos de acompanhamento e a acelerar o desenvolvimento de estratégias diagnósticas e terapêuticas que combinem reabilitação cognitiva, manejo de sintomas e intervenções baseadas em mecanismos, respeitando a diversidade de manifestações clínicas observadas nas pessoas afetadas.

Em síntese, a pesquisa esclarece pontos centrais sobre a base biológica da névoa mental na COVID longa e abre caminho para ferramentas diagnósticas objetivas e terapias mais eficazes. Ao conectar relatos de dificuldade de atenção, memória e velocidade de processamento a uma alteração mensurável nos receptores de glutamato, oferece uma ponte entre experiência subjetiva e sinal molecular, e lembra que compreender o que sentimos passa por observar as sinapses em funcionamento, onde a aprendizagem e a memória encontram as marcas de uma doença que ainda estamos aprendendo a decifrar.

Referência:

A COVID longa apresenta-se principalmente com comprometimento cognitivo persistente (Cog-LC), impondo um ônus global substancial e duradouro. Mesmo após a pandemia, permanece uma necessidade mundial crítica por estratégias diagnósticas e terapêuticas direcionadas ao Cog-LC. Ainda assim, os mecanismos neurais subjacentes permanecem pouco compreendidos. Dado o papel central das sinapses na função cerebral, a investigação de alterações moleculares sinápticas pode fornecer insights vitais sobre a fisiopatologia do Cog-LC. Neste estudo, utilizamos PET com [11C]K-2 para caracterizar a densidade de receptores AMPA (AMPARs) na superfície celular pós-sináptica, que são componentes sinápticos cruciais na sinalização cerebral. Empregou-se mapeamento paramétrico estatístico para normalizar espacialmente e aplicar teste t independente em uma comparação baseada em voxels. https://academic.oup.com/braincomms/article/7/5/fcaf337/8258475

Clique em um idioma para traduzir.

Este blog está licenciado sob uma

Licença Creative Commons Atribuição 4.0 Internacional

.

Ouça o artigo: Você já ouviu falar em "conflitos híbridos" ou "guerra da informação...