Referência:

Começo com uma pergunta que talvez nunca tenha atravessado sua cabeça durante uma dor de cabeça banal: o que acontece se uma molécula tão cotidiana como o paracetamol encontra um embrião nas primeiras horas de vida, quando tudo o que existe é um punhado de células tentando se duplicar no tempo certo? Um estudo experimental recente abriu uma janela incômoda sobre esse encontro e apontou um mecanismo biológico simples, porém decisivo: o fármaco pode desacelerar o ciclo celular logo no início do desenvolvimento, reduzindo a síntese de DNA e travando as divisões que deveriam avançar com precisão de relógio.

Para entender por que esse achado chama atenção, vale situar a cena. A etapa de pré-implantação (período entre a fecundação e o momento em que o embrião se fixa no endométrio) é um corredor estreito do desenvolvimento humano. Em poucos dias, o zigoto passa por clivagens sucessivas, vira mórula e então blastocisto, uma esfera com duas populações celulares: a massa celular interna (ICM, do inglês inner cell mass), que dará origem ao feto, e o trofectoderma (TE), que formará a interface com o útero e parte das membranas. Cada divisão precisa acontecer com ritmo e qualidade. Pequenos atrasos, acúmulos de dano ou desbalanceamento entre ICM e TE podem significar um fim silencioso para aquela gestação, antes mesmo de uma menstruação atrasar.

Num cenário ideal, a escolha analgésica durante a tentativa de engravidar deveria ser trivial, quase um detalhe. Só que o paracetamol está por toda parte: é vendido sem receita, integra centenas de formulações e é amplamente usado por mulheres em idade reprodutiva. Exatamente por ser percebido como “leve”, sua presença discreta no cotidiano pode se somar a uma coincidência biológica: o embrião muito jovem é, em essência, uma máquina de copiar DNA. Perturbar esse processo por algumas horas pode ter um impacto desproporcional.

O trabalho que inspira esta análise não ficou apenas em cultura de uma linhagem celular e um gráfico elegante. A equipe percorreu vários níveis de complexidade: leveduras (Schizosaccharomyces pombe) como sistema vivo simples para testar hipóteses de mecanismo; células humanas em cultura, incluindo células embrionárias pluripotentes; embriões de camundongo expostos ex vivo a concentrações crescentes; embriões humanos descartados de tratamentos de fertilidade, monitorados por time-lapse; e, em paralelo, medições de paracetamol em fluidos reprodutivos de mulheres após dose analgésica padrão. A força do desenho não está em um número colossal por braço, e sim na repetição de um padrão biológico ao cruzar espécies, modelos e técnicas.

Qual seria o alvo central? A pista surge de uma enzima antiga e essencial: a ribonucleotídeo redutase (RNR). Ela converte ribonucleotídeos em desoxirribonucleotídeos, os tijolos do DNA. Sem RNR funcionando direito, a célula entra em estresse replicativo: tenta copiar o genoma, mas a matéria-prima falta, as forquilhas de replicação emperram e o ciclo acumula células na fase S (fase do ciclo celular em que o DNA é duplicado). Em leveduras, que não contam com os alvos clássicos do paracetamol (como COX-1/COX-2), a exposição à molécula reduziu a proliferação e gerou um perfil compatível com bloqueio de RNR. Quando os pesquisadores colocaram a versão “humanizada” da RNR nas leveduras, a sensibilidade ao fármaco aumentou, reforçando que o nó pode estar exatamente aí: menos desoxirribonucleotídeo, menos DNA novo, menos células filhas.

Se isso fosse apenas uma curiosidade de microrganismo, pouco mudaria nossa prática. Então o teste avança para células humanas. Em HEK293 (rim embrionário humano) e em células-tronco embrionárias (linhagens H1 e HUES4), uma exposição de poucas dezenas a centenas de micromolar não matou as células, mas diminuiu o número total ao longo do tempo e acumulou a população na fase S, exatamente como se a replicação tivesse perdido a fluidez. A síntese de DNA, medida por incorporação de EdU (um análogo de nucleosídeo que marca DNA recém-sintetizado), caiu. O padrão se repetiu: não era necrose difusa; era replicação mais lenta. E isso é o que mais importa num embrião.

A etapa seguinte foi colocar o efeito no contexto do desenvolvimento. Embriões de camundongo em estágio de duas células foram expostos por 24 a 48 horas a concentrações que iam de 10 a 200 µM. Enquanto controles avançavam para blastocisto com o número esperado de blastômeros (células resultantes das clivagens iniciais), os embriões expostos passaram a estacionar em estágios mais precoces, com menos células e menor taxa de blastocisto. Quando já eram blastocistos e recebiam o fármaco por 24 horas, o total de células até podia se manter, mas a ICM encolhia de forma dose-dependente, um detalhe crítico, porque a ICM é o núcleo do projeto fetal. Reduzir essa pequena população pode comprometer tudo que virá depois.

E quanto aos embriões humanos? Em laboratório, blastocistos e embriões em clivagem expostos por poucas horas a 100–200 µM mostraram diminuição de síntese de DNA e menor número de células após o período de cultura. Tem um detalhe anatômico que ajuda a visualizar: em blastocistos saudáveis, a ICM forma um grupamento claro de células que expressam marcadores como OCT3/4 (associado à pluripotência), enquanto o TE expressa CDX2. Com a droga, essa organização fica mais pobre, às vezes com a ICM menos definida. Não é um colapso súbito, como um botão off; é mais parecido com uma embreagem patinando: a máquina tenta andar, mas não entrega a mesma força.

Talvez você esteja pensando: “ok, mas essas concentrações fazem sentido no mundo real?” É uma pergunta justa. O estudo mediu paracetamol em fluido folicular, endométrio e líquido uterino de mulheres que receberam 1 g como analgesia em procedimentos ginecológicos. Achou níveis detectáveis nesses compartimentos perto do período em que um embrião naturalmente trafegaria. Outras referências apontadas pelos autores indicam que exposições padrão podem levar a concentrações plasmáticas acima de 100 µM, o que deixa a janela de plausibilidade aberta: as doses clínicas não estão a oceanos de distância do que causa atraso replicativo in vitro. Não se trata de dizer que tomar um comprimido inviabiliza uma gestação; a leitura sensata é que a margem de segurança pode ser mais estreita do que supúnhamos para um tecido em rápida divisão.

Outro pedaço do quebra-cabeça é metabolismo. Em cultura, após 72 horas com 500 µM, o meio apresentava majoritariamente o próprio paracetamol e seu conjugado sulfato. O metabólito NAPQI, famoso por ser o vilão nas hepatotoxicidades por superdosagem, não apareceu como protagonista nesse contexto. Isso reforça a ideia de um efeito direto da molécula-mãe, potencialmente interferindo no sítio radical da subunidade β da RNR, onde um radical tirosila e um centro di-férrico participam da química que mantém a enzima ativa. É um detalhe bioquímico, mas ele dá coerência ao quadro: se não é morte celular tóxica, e sim freio replicativo, o alvo enzimático faz sentido.

O estudo também olhou a gestação de camundongos sob exposição repetida ao paracetamol por via oral durante a janela de acasalamento e início da gestação. O desfecho foi avaliado no fim da prenhez, com contagem de fetos e de reabsorções (sinais de perda embrionária). Embora detalhes estatísticos finos dependam da leitura das tabelas, a direção dos resultados aponta para impacto reprodutivo quando a exposição ocorre nesse período crítico. A mensagem que emerge no conjunto é que pequenas diferenças na velocidade de divisão no começo podem se traduzir, lá adiante, em menos implantações bem-sucedidas.

Vale a pena reforçar o ponto-chave: quando o tecido alvo é altamente proliferativo e nada é mais proliferativo do que um embrião nos primeiros dias, qualquer molécula que mexa com a disponibilidade de desoxirribonucleotídeos ou com o tempo de passagem pela fase S pode deslocar a balança. O paracetamol não é uma “droga antiproliferativa” no uso cotidiano, é um analgésico e antipirético. Só que o contexto biológico muda o significado farmacológico. A mesma propriedade que parece irrelevante num fígado saudável pode ganhar peso desproporcional quando o alvo involuntário é um aglomerado de células recém-nascidas.

Evidentemente, existem limitações. O número de embriões humanos em clivagem disponíveis para experimento é pequeno; mesmo com blastocistos em maior quantidade, continua sendo um recorte. Exposições in vitro controlam variáveis que a vida real mistura, fluxo sanguíneo, farmacocinética, tempos de pico, efeitos compensatórios. Associação clínica direta entre uso de paracetamol e perda embrionária precoce exige coortes prospectivas e um desenho epidemiológico que considere confusão por indicação (por que a paciente tomou o remédio?), outras exposições concomitantes e diferenças individuais de metabolismo. O estudo não tenta pular essas etapas; ele descreve um mecanismo, mostra que concentrações plausíveis fazem diferença, e sugere com sobriedade que vale investigar mais.

O paracetamol é onipresente em rios e águas superficiais em vários países, e a exposição de fundo já foi detectada em populações europeias. Isso não significa que há risco imediato a embriões humanos a partir de traços ambientais; significa, isso sim, que vivemos cercados por uma molécula que circula nos nossos sistemas biológicos, às vezes sem que percebamos. Quando se fala de janela de vulnerabilidade biológica, dose e tempo se tornam tão relevantes quanto a identidade da substância. Uma dose única no momento errado pode ser mais impactante do que várias doses em um período indiferente do ciclo reprodutivo.

Você pode perguntar: o que uma pessoa tentando engravidar faz com essa informação? A resposta razoável é prudência informada. Não é necessário demonizar um analgésico útil; dá para reduzir uso desnecessário, evitar automedicação nos dias de maior chance de concepção e, principalmente, conversar com o médico sobre alternativas e estratégias de manejo da dor e febre nesse período. Doses, intervalos e necessidade real de cada tomada importam. Às vezes, uma compressa fria, hidratação e repouso resolvem uma cefaleia transitória que você medicaria por reflexo.

O mesmo raciocínio vale para febre, uma condição que, por si só, pode ser indesejada durante a concepção e início da gestação. Fazer o balanço risco-benefício com o profissional de saúde ajuda a manter o controle térmico sem expor o embrião a picos desnecessários de qualquer substância. E se o paracetamol for a escolha, pensar “menos é mais” quando possível, dentro do que é clinicamente adequado, parece sensato.

Há um elemento técnico que merece ser repetido, justamente para fixar a ideia: o alvo proposto — a RNR — é conservado de leveduras a humanos. Isso explica por que o padrão apareceu em tantos modelos, e também por que a fase S virou um ponto de convergência dos resultados. Em linguagem simples, o paracetamol passou a régua onde a célula mais precisava de fluidez. Quando o tecido é o embrião, esse pequeno desacerto de timing pode somar-se a outras variáveis e empurrar o sistema para um desfecho pior. Guardar esse mapa mental ajuda a interpretar futuras pesquisas e notícias sobre o tema.

Outro aspecto didático: o estudo observou que, em blastocistos expostos, a ICM tende a ficar menor. Faz sentido biológico. A ICM é um núcleo de pluripotência que precisa de massa mínima para sustentar diferenciações subsequentes. Um déficit inicial pode reverberar em organogênese e até em eixos como gônadas e sistema nervoso, que têm janelas temporais delicadas. Isso não é uma profecia sobre malformações a partir de uma dose isolada; é uma hipótese plausível que justifica vigiar com lupa possível impacto de exposições repetidas ou de picos coincidindo com dias críticos.

Estamos falando de ciência em andamento. Resultados como esses, quando chegam ao debate público, costumam provocar extremos: “é seguro, sempre foi” de um lado; “é perigoso, não use nunca” do outro. A postura mais útil fica no meio: evidência mecanística consistente somada a indícios de exposição plausível pedem estudos clínicos bem desenhados. Enquanto eles não chegam, dá para ajustar comportamento com leveza: evitar “toma e vê”; registrar quando e por que tomou; considerar analgésicos alternativos se aconselhados pelo médico; priorizar medidas não farmacológicas para dores triviais.

Pergunte a si mesmo: eu preciso mesmo desse comprimido hoje? Se a resposta for sim e muitas vezes será, tome dentro do intervalo terapêutico e com acompanhamento. Se a resposta for “talvez”, existem caminhos que não passam por uma molécula que, em um contexto muito específico, mostrou capacidade de travar a duplicação do DNA por horas. No começo da vida, horas contam.

Antes de encerrar, deixo um lembrete central: o estudo não propõe pânico, propõe atenção. Ele não diz que toda exposição levará a perda embrionária; demonstra que o mecanismo existe, que aparece cedo, que se reproduz em sistemas diferentes e que dialoga com níveis observados no trato reprodutivo após dose clínica comum. Esse conjunto, por si só, já muda a qualidade da conversa entre quem tenta engravidar e quem orienta o cuidado.

Em ciência, um resultado vale pelo que explica e pelo que permite perguntar. Aqui, as perguntas que ficam são claras. Quais são as janelas de maior vulnerabilidade durante o ciclo? Há diferenças individuais de metabolismo que amplifiquem ou atenuem o efeito? Como febre, estresse e outras medicações modulam o quadro? O que os dados de coorte dirão quando acompanharmos tentantes com um diário de uso real e marcadores hormonais? Enquanto essas respostas chegam, a mensagem prática é simples: informação, parcimônia, diálogo clínico, três ferramentas baratas que protegem decisões em períodos em que cada detalhe pode pesar.

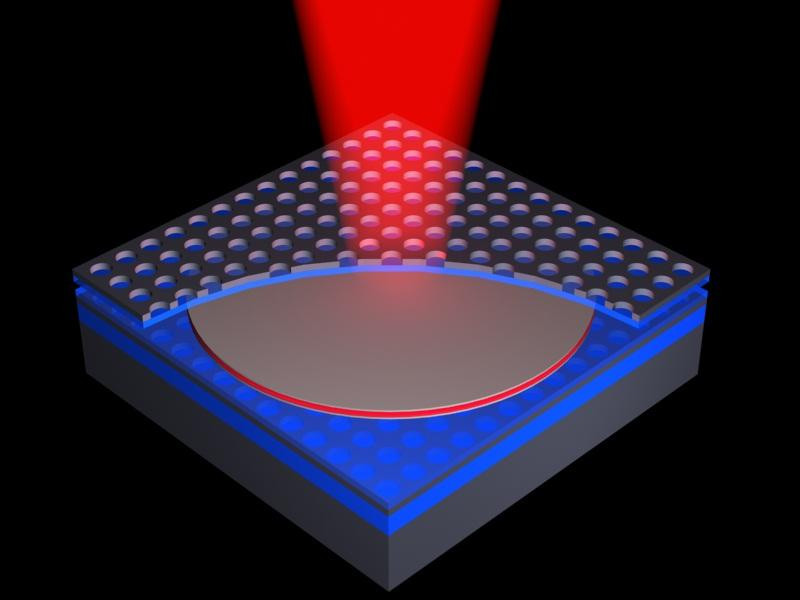

Peças fundamentais de computação e criptografia quânticas precisam de fontes de fótons compactas, integráveis e, principalmente, controláveis. Não basta emitir luz: é preciso esculpir cada fóton, decidir para onde ele vai, como ele vibra e com que intensidade aparece. Parece pedir demais de um componente micrométrico? A equipe de Fei Ding, na Universidade do Sul da Dinamarca, resolveu encarar exatamente essa ambição: mostraram uma técnica que controla direção, polarização e intensidade ao mesmo tempo, a partir de uma única arquitetura em estado sólido.

A aposta não nasce do zero. O caminho passa por metassuperfícies (metasurfaces), camadas ultrafinas com nanoestruturas que convertem excitações de superfície em luz propagante. A novidade está na forma dos elementos que compõem essa camada e na maneira como essa geometria dá acesso independente aos “botões” da emissão. O resultado prático? Feixes únicos ou múltiplos, apontando para onde se deseja, com polarizações distintas (linear ou circular) e relações de intensidade programáveis, tudo saindo de uma plataforma que cabe em um chip.

Queremos tecnologias quânticas escaláveis, fabricáveis em série e que conversem com a microeletrônica atual. Isso exige fontes de fótons em estado sólido, nada de equipamentos volumosos de bancada para cada experimento. Para computação quântica fotônica e para redes quânticas, o fóton é o mensageiro de informação. Ter controle fino sobre direção (o para onde), polarização (a orientação do campo elétrico da onda) e perfil espacial (o desenho do feixe) é condição de contorno para qualquer arquitetura séria. Pergunta: sem esse controle, como acoplar luz a guias de onda, divisores, detectores e nós lógicos com eficiência e repetibilidade?

O dispositivo começa com um “sanduíche” meticulosamente montado: 30 nm de dióxido de silício sobre um espelho de prata de 150 nm. No topo, entra o emissor quântico, um nanodiamante com centros NV (nitrogênio emparelhado a lacunas de carbono), famoso por gerar fótons únicos quando excitado por laser. O pulso chega, o emissor responde e aciona polaritons plasmônicos de superfície (SPPs): ondulações híbridas que misturam campo eletromagnético com movimentos de carga ao longo do metal.

Essas ondas de superfície se espalham e encontram uma “clareira” desenhada com precisão: uma matriz de tiras de prata de 35 nm de espessura, espaçadas de 200 nm, que funcionam como nanoantenas. Cada tira intercepta a energia do SPP e a reradia como luz no espaço livre. Esse é o momento crucial: a forma e a orientação dessas nanoantenas definem como a energia vira fóton e que fóton sai.

Experimentos anteriores usavam elementos mais simétricos. O grupo escolheu retângulos. Por quê? Porque retângulos são anisotrópicos: apresentam respostas distintas conforme a direção do campo que chega. Essa assimetria dá uma alavanca extra, a possibilidade de controlar independentemente as fases das duas componentes de polarização circular (esquerda e direita) do fóton emitido. Traduzindo: quem controla a fase de cada componente circular controla a polarização final (linear, circular, elíptica) e o perfil espacial do feixe.

E não é só um feixe, a mesma estratégia programa vários feixes saindo simultaneamente, apontando para direções diferentes e exibindo polarizações distintas, com proporções de intensidade escolhidas no projeto. O arranjo completo tem cerca de 10 micrômetros de largura, dimensões plenamente compatíveis com rotas de integração em fotônica de silício e vizinhança.

Para garantir desempenho robusto, os pesquisadores organizaram as nanoantenas em geometrias como discos ou anéis (uma “rosquinha” micrométrica). O formato maior ajuda na estabilidade e no gerenciamento do acoplamento às ondas de superfície. Ainda assim, o tipo de polarização produzido não é ditado por esse contorno amplo; ele nasce da composição precisa das antenas retangulares lá dentro, a coreografia fina que decide se a luz sai linear, circular ou algo entre uma coisa e outra.

A peça-chave é a independência dos controles. A plataforma anterior já convertia SPPs em luz, mas faltava um painel que permitisse girar, separadamente, os botões de direção, polarização e intensidade e fazê-lo de forma generalizável. Agora há um framework único que gera:

um feixe único na direção desejada, com polarização definida com capricho,

ou múltiplos feixes em direções diferentes, com polarizações diferentes e razões de intensidade programadas,

sem abandonar a compacidade nem apelar para “gambiarras” fora do chip.

Quem trabalha com nanofotônica e com óptica integrada enxerga o valor imediato: há um caminho prático para rotear fótons como se fossem sinais elétricos, configurando portas, cruzamentos e multiplexadores com o grau de liberdade extra que a polarização oferece.

Por que isso importa para o mundo quântico? Computadores, sensores e links quânticos dependem de fótons solteiros com propriedades controladas. Em computação fotônica, a polarização pode codificar qubits; em comunicações, ela participa do entrelaçamento e de protocolos segurança-críticos. Direcionar emissão com precisão economiza perdas de acoplamento e melhora taxas de detecção, o que, na prática, significa menos erros e menos recursos para correção.

Quer um exemplo concreto? Projetar um chip que emita dois feixes correlacionados, cada um alimentando um circuito diferente, sem precisar mover a fonte, simplifica topologias de fontes entrelaçadas on-chip. Outro exemplo: escolher polarização circular específica para excitar modos quiralmente seletivos em guias ou cavidades. Quanto mais “dócil” for a fonte, mais elegante e compacto fica o desenho do restante do sistema.

Vale desacelerar um instante e olhar o mecanismo com lupa. O SPP traz fase e direção codificadas pelo emissor e pela metassuperfície. As nanoantenas retangulares “amostraram” essa onda e a espalharam como dipolos radiantes cuja fase relativa pode ser ajustada via posição, orientação e dimensões. Como a polarização circular pode ser decomposta em duas helicidades (esquerda e direita), manipular separadamente a fase de cada helicidade equivale a ter dois canais independentes que, recombinados, dão a polarização desejada. É uma espécie de sintetizador vetorial em escala nanométrica: componha dois vetores com fases e amplitudes que você escolhe e o resultado final aponta e gira como planejado.

Essa gramática geométrica também dita para onde a luz vai. Ao distribuir antenas com gradientes de fase impressos no espaço, criam-se padrões de interferência que “lançam” o feixe em ângulos específicos, uma antena phased-array em miniatura. O mesmo princípio, replicado em setores diferentes da estrutura, libera múltiplos feixes simultâneos.

Centros NV em diamante são veteranos da fotônica quântica: emitem fótons sob excitação por laser, toleram bem temperatura ambiente em certas aplicações e têm níveis de energia que permitem leitura óptica. Integrá-los a uma plataforma metal-dielétrica (prata e SiO₂) traz o melhor de dois mundos: um emissor quântico robusto e uma metassuperfície engenheirável. O “telefônico” dessa conversa é a eficiência com que o SPP vira fóton útil. Ali entram otimizações de espessuras, índices e distâncias para drenar o máximo de energia da onda de superfície para o feixe no espaço livre.

A mensagem se repete: controle total da emissão — direção, polarização e intensidade — não é capricho acadêmico; é pré-requisito para escalar tecnologias quânticas e nanofotônicas. Plataformas com um só grau de liberdade já provaram limite. É a combinação simultânea que muda o jogo de design.

Para quem desenha geradores, moduladores e gerenciadores de luz, a integração de fontes de fótons únicos dentro da metassuperfície é uma ponte curta entre laboratório e dispositivos reais. O trabalho atual faz eco a anos de pesquisa em metasuperfícies, mas troca a luz clássica por fontes quânticas e amplia o leque de controle de forma paramétrica. A leitura otimista é direta: ficou mais fácil planejar fontes sob medida para arquiteturas fotônicas específicas, sem reescrever todo o processo a cada novo requisito.

Próximo passo sensato: emissão elétrica on-chip. Bombear com laser funciona para prova de conceito e medições. Para escala industrial, o ideal é bombear eletricamente o emissor quântico, tal como fazemos com LEDs e lasers de diodo. A própria equipe mira integrar essa plataforma a emissores acionados por corrente, reduzindo complexidade de ótica externa e aproximando o componente do ecossistema de circuitos integrados. Faz sentido: quem quer uma fábrica inteira de lasers apenas para alimentar cada fonte em um chip?

A trajetória recente da fotônica quântica sugere que os blocos-de-montar certos — emissores quânticos estáveis, metassuperfícies projetáveis, antenas nanoestruturadas — estão convergindo para bibliotecas de projeto. A contribuição aqui é uma biblioteca mais expressiva: com as mesmas peças, é possível escrever “frases” óticas diferentes, isto é, feixes com direções, polarizações e intensidades escolhidas à vontade.

Pergunta final, que vale tanto para quem pesquisa quanto para quem pretende usar: que aplicações ganham vantagem imediata com um “sintetizador de fótons” on-chip? Candidatos naturais aparecem: chaves e roteadores quânticos em redes metropolitanas, fonte dual de fótons para protocolos de teste de Bell integrados, interfaces quiralmente seletivas para acoplar fótons a qubits de matéria. Quando a fonte passa a obedecer ao projeto, o resto do circuito agradece.

Transformar a ondulação de superfície de um metal em feixes sob encomenda era uma ideia elegante; transformá-la em uma caixa de ferramentas com três botões independentes — direção, polarização, intensidade — aproxima a fotônica quântica do tipo de engenharia modular que fez a microeletrônica decolar. O chip ainda é pequeno.

Bits se parecem com interruptores: ligados ou desligados. Qubits jogam outro jogo. Pense em uma moeda girando no ar — antes de cair, ela está, de certo modo, em “cara” e “coroa” ao mesmo tempo. É esse comportamento, estranho para a intuição cotidiana, que sustenta a computação quântica. Quando a lógica binária encontra limites, a mecânica quântica oferece um repertório de possibilidades que se combinam e interferem.

Um qubit (quantum bit) é a unidade básica de informação em um computador quântico. Um bit clássico assume 0 ou 1. O qubit pode ocupar uma superposição (combinação linear de estados) descrita por ψ = α|0⟩ + β|1⟩, em que α e β são amplitudes complexas. No ato da medida (observação com um aparelho), a superposição colapsa para 0 ou 1 com probabilidades proporcionais a |α|² e |β|². Parece paradoxal? O ganho computacional nasce justamente dessa sobreposição de possibilidades antes do registro final.

Com n qubits, o espaço de estados tem tamanho 2ⁿ. Dez qubits já codificam 1.024 configurações simultâneas; cinquenta chegam à casa do quadrilhão. Não é que o computador “faça tudo ao mesmo tempo”, e sim que algoritmos habilidosos exploram interferências para reforçar as respostas corretas e cancelar as erradas.

A ideia tomou forma nos anos 1980. Paul Benioff propôs uma máquina de Turing descrita por leis quânticas, e Richard Feynman defendeu que sistemas quânticos seriam os melhores simuladores de si mesmos. Entre o papel e o hardware, havia um abismo: fabricar objetos físicos que realmente sustentassem superposição e coerência (manutenção de fases quânticas) tempo suficiente para calcular.

Além da superposição, qubits podem exibir emaranhamento (correlações não clássicas entre sistemas). O exemplo de vitrine é o estado de Bell (|00⟩ + |11⟩)/√2. Medir o primeiro qubit dá 0? O segundo, medido na mesma base, retorna 0 com correlação perfeita. Einstein apelidou o fenômeno de “ação fantasmagórica à distância”. O que isso diz sobre o real? Que certas relações só fazem sentido quando tratadas pelo formalismo quântico.

Teoria só ganha corpo quando há uma implementação física.

Qubits supercondutores. Em chips resfriados a frações de kelvin, o material torna-se supercondutor e permite circuitos artificiais — transmons, fluxonium — cujo comportamento é regido por níveis quânticos. Empresas como Google e IBM investem nessa rota. Em 9 de dezembro de 2024, o grupo de IA quântica do Google apresentou o Willow, com 105 qubits supercondutores e foco explícito em reduzir erros à medida que a escala cresce. Essa é a fronteira que realmente importa: mais qubits só ajudam se o fator qualidade acompanhar.

Pesquisadores na Rússia relatam qubits baseados em “átomos artificiais” sobre arseneto de gálio, com controle de carga e spin via campo elétrico, além de operações de um qubit no patamar de 99,993% em arquiteturas tipo fluxonium. A mensagem é clara: robustez e controlabilidade são tão decisivas quanto o número bruto de qubits.

Em armadilhas iônicas, qubits são átomos carregados suspensos por campos eletromagnéticos, manipulados por lasers com fidelidades altíssimas. Já os fótons suportam operações em temperatura ambiente e viabilizam esquemas como amostragem de bósons; equipes chinesas produziram demonstrações fotônicas ambiciosas (como a família “Jiuzhang”), úteis para tarefas específicas.

Cada plataforma troca vantagens: supercondutores escalam integração com microeletrônica; íons oferecem fidelidades excepcionais; fótons simplificam transmissão e detecção. Qual caminho vence? Talvez nenhum sozinho.

Qubits são sensíveis. Interações com o ambiente, vibrações, calor, ruído eletromagnético, provocam decoerência (perda de informação de fase). O “relógio” útil é o tempo de coerência. Em muitas arquiteturas, fala-se de dezenas de microssegundos; grupos vêm relatando milissegundo em transmons bem projetados. Parece pouco? Em escala quântica, uma milissegundo permite milhares de portas lógicas. A corrida é dupla: ganhar coerência e encurtar circuitos via melhores algoritmos e compilações.

Para que serve um computador quântico? Não é uma máquina “melhor para tudo”. É uma máquina excelente para certas classes de problemas.

Criptografia: O algoritmo de Shor fatoraria inteiros grandes com eficiência, afetando esquemas como RSA. Falta escala prática: demanda milhões de qubits lógicos (qubits “efetivos” após correção de erros). O mercado já se antecipa com criptografia pós-quântica em navegadores e protocolos.

Química e materiais: Moléculas obedecem leis quânticas; simular seus estados eletrônicos cresce em complexidade de forma explosiva. Qubits podem atacar regras de correlação eletrônica que travam métodos clássicos, acelerando a busca por catalisadores, fármacos e materiais com propriedades sob medida.

Otimização: Roteamento, alocação, despacho de energia. Algoritmos variacionais e máquinas de annealing quântico exploram paisagens de custo com heurísticas novas. A promessa é dividi-las de modo híbrido: partes clássicas estruturam o problema, rotinas quânticas tratam subproblemas difíceis.

2025 foi declarado Ano Internacional da Ciência e Tecnologia Quânticas. A fotografia do momento inclui:

Processadores maiores (IBM Osprey com 433 qubits em 2022), mas a comunidade aprendeu a não confundir contagem de qubits com potência útil.

Qubits lógicos ganhando tração: esforços acadêmicos, como o grupo de Mikhail Lukin, demonstram codificação e controle na casa de dezenas de lógicos — peça-chave porque um qubit lógico exige muitos qubits físicos.

Planos nacionais surgindo com metas explícitas (famílias de 75 qubits a curto prazo e centenas a médio prazo), sinalizando priorização estratégica.

É aqui que um ponto merece ser reforçado mais adiante: qualidade, fidelidade e taxa de erro pesam mais que contadores de qubits em slides.

A mecânica quântica proíbe clonagem exata de estados desconhecidos (o no-cloning theorem). Como então proteger informação contra ruído? A saída é codificação quântica: representar um qubit lógico em muitos qubits físicos e detectar/mitigar erros sem “medir o estado” diretamente. O preço é alto. Estruturas completas de correção pedem milhões de qubits físicos para algumas centenas ou milhares de lógicos. Também há obstáculo de engenharia: cada qubit extra traz fiação, controle e dissipação dentro do criostato. Não surpreende ver propostas como bolometria em grafeno para leitura mais eficiente e de baixa potência. Otimização térmica e eletrônica é tão vital quanto teoria de códigos.

Em 2019, o Sycamore (53 qubits, Google) executou uma amostragem aleatória em ~200 segundos, alegadamente inalcançável por supercomputadores em tempos razoáveis. A IBM contestou, estimando que o Summit poderia reproduzir a tarefa em alguns dias com aproximações. Qual a lição? Supremacia quântica é um marco de tarefa, não um selo universal. O foco migra para vantagem quântica prática: resolver problemas relevantes melhor do que alternativas clássicas reais.

Uma linha que desperta expectativa usa quasipartículas de Majorana para criar qubits topológicos, em tese, naturalmente protegidos contra certos ruídos. A Microsoft divulgou o Majorana 1 em 19 de fevereiro de 2025, baseado em materiais com propriedades topológicas (condutores/supercondutores projetados). Se a proteção topológica se comprovar em escala, o custo de correção pode cair, encurtando a estrada até máquinas úteis.

A visão mais sóbria aponta para sistemas híbridos. Processadores clássicos continuam no comando do grosso do cálculo; aceleradores quânticos atacam subrotinas de otimização, simulação química e aprendizado onde a vantagem seja demonstrável. A pergunta: isso os tornará onipresentes? Provavelmente não. A aposta é em nicho de alto impacto, com integração de software e nuvem escondendo a complexidade quântica do usuário final.

Escala por escala não fecha a conta sem qualidade. Fidelidade de portas, taxa de erro por ciclo, profundidade de circuito e tempo de coerência determinam se um algoritmo sai do quadro-negro e roda no chip. É tentador comparar só “número de qubits”, mas essa métrica isolada engana. O progresso mais transformador pode vir de redução drástica de erros, mesmo com contagens modestas.

Onde estamos, em termos práticos?

Criptografia pós-quântica entra em produtos correntes para mitigar risco futuro.

Simulação molecular começa a sair do estágio de prova de conceito em instâncias pequenas, com pipelines que combinam etapas clássicas e quânticas.

Otimização industrial testa protótipos variacionais sob métricas de custo reais.

Sensoriamento quântico avança em gravimetria, magnetometria e relógios atômicos — áreas onde a mecânica quântica já rende vantagens tangíveis.

Qubits inauguram uma maneira diferente de processar informação. São temperamentais, pedem extremos criogênicos e rotinas de controle precisas, e ainda resolvem uma fração estreita de problemas. O horizonte de um computador quântico universal permanece distante, mas os tijolos já formam pontes úteis. Se a metáfora da moeda girando ajuda, vale acrescentar outra: o desafio não é só manter a moeda no ar; é coreografar muitas moedas, fazê-las colidir de modos controlados e ler o padrão resultante sem que o ambiente estrague a dança.

Este blog está licenciado sob uma

Licença Creative Commons Atribuição 4.0 Internacional

.

Ouça o artigo: Você já ouviu falar em "conflitos híbridos" ou "guerra da informação...