Como as práticas agrícolas estão enfraquecendo o solo

Provavelmente você está lendo este texto em um computador, um tablet ou um smartphone, certo? Vale a pena voltar no tempo para entender como chegamos aqui. Em 1981, a IBM lançou o PC modelo 5150. Ele não foi o primeiro computador pessoal, porém se tornou o mais influente por definir padrões de hardware e software que reorganizaram um mercado fragmentado. Nesta leitura didática, você vai ver por que aquela máquina, que hoje parece um trambolho, virou a base da era digital.

No início dos anos 1980, existiam ótimos micros, como Apple II, TRS-80 e Commodore PET. Cada um era um universo próprio, com sistema, periféricos e programas específicos. Um software comprado para Apple II não funcionava no TRS-80, e assim por diante. Desenvolvedores precisavam portar versões diferentes do mesmo programa, usuários ficavam presos ao ecossistema escolhido, empresas hesitavam em adotar em larga escala. Nesse cenário, a IBM, gigante dos mainframes, observava à distância, perdendo espaço para minicomputadores e para os novos microcomputadores. O mercado de PCs já crescia mais de 40% ao ano, movendo bilhões de dólares. Ignorar deixou de ser opção.

Ainda em 1980, a diretoria incumbiu uma equipe de criar um PC para consumidores em cerca de um ano, algo impensável para a cultura tradicional da empresa. A equipe adotou decisões radicais para ganhar velocidade, como utilizar componentes prontos do mercado e, principalmente, definir uma arquitetura aberta. Em 12 de agosto de 1981, no Hotel Waldorf Astoria, em Nova York, o IBM PC 5150 foi apresentado. O preço de entrada variava conforme a configuração, posicionando a máquina para escritórios e entusiastas.

CPU: Intel 8088 a 4,77 MHz. Ele era mais barato e disponível do que alternativas, e mantinha compatibilidade com a família 8086, o que favorecia a adoção.

Memória: 16 KB no básico, expansível, chegando a 640 KB com placas e bancos adicionais.

Armazenamento: versões sem disco, com interface para gravador de fitas; na prática, quase todos vinham com uma ou duas unidades de disquete de 5¼", com 160 KB ou 320 KB.

Vídeo: saída textual monocromática em monitores como o MDA, medido em caracteres em vez de pixels nas configurações de texto; opções gráficas surgiram via placas.

Expansão: cinco slots ISA. Este foi um divisor de águas, pois permitia adicionar placas de vídeo, som, portas, memória e até discos rígidos.

O mais importante do que a lista técnica foi a estratégia: a IBM publicou documentação detalhada do hardware e do BIOS, estimulando terceiros a criar periféricos e software. Essa abertura acelerou a formação de um ecossistema vibrante.

Ao optar pela arquitetura x86 da Intel, a IBM semeou o padrão que dominaria PCs por décadas. Para o sistema operacional, a empresa tentou negociar com o fornecedor do popular CP/M, porém o acordo não prosperou. A IBM então fechou com a Microsoft, que licenciou um sistema chamado 86-DOS, renomeado como MS-DOS. Um ponto estratégico ocorreu aqui: a Microsoft manteve o direito de licenciar o MS-DOS a outros fabricantes, o que permitiu que o sistema se tornasse padrão da indústria e preparou o terreno para o Windows, que mais tarde viria com interface gráfica. Essa combinação x86 + MS-DOS criou uma base comum para fabricantes, desenvolvedores e usuários.

A publicação do design e do BIOS, somada à estrutura modular, abriu espaço para a engenharia reversa legal do BIOS por terceiros e para o surgimento dos clones compatíveis com IBM. Empresas como Compaq, Dell e outras produziram PCs mais baratos e acessíveis, mantendo compatibilidade com o software do ecossistema IBM. O efeito foi duplo, para a sociedade, houve queda de preços e padronização, democratizando a computação em casas e escritórios. Conforme a IBM, a consequência foi a perda gradual do controle sobre o padrão que ela mesma criou.

A marca IBM transmitia confiança ao mercado corporativo. Sua entrada validou o PC como ferramenta séria de trabalho. Em 1983, o lançamento da planilha Lotus 1-2-3 tirou proveito do hardware do PC e virou o primeiro “killer app”, impulsionando vendas no mundo corporativo, pois resolvia um problema de negócios com ganho claro de produtividade. Software útil, padrão aberto e marca confiável criaram um ciclo virtuoso de adoção.

Evolução rápida: XT, AT e o tropeço do Micro Channel

IBM PC XT (1983): trouxe disco rígido interno de 10 a 20 MB e mais expansão, reduzindo a dependência de disquetes e melhorando fluxos de trabalho.

IBM PC AT (1984): adotou o processador Intel 80286 e barramento de 16 bits, oferecendo de três a seis vezes mais desempenho e ampliando a capacidade do sistema.

PS/2 e MCA (1987): tentando retomar o controle do padrão, a IBM lançou a arquitetura Micro Channel (MCA), tecnicamente superior ao ISA, porém proprietária e cara de licenciar. O mercado, já habituado à abertura, reagiu com o EISA, mantendo compatibilidade e filosofia aberta. O resultado consolidou o padrão aberto fora do domínio direto da IBM.

O PC transformou a cultura popular e o trabalho. E já em 1982, a revista Time nomeou o computador pessoal como “Máquina do Ano”, evidenciando o impacto social. A IBM veiculou campanhas com o personagem de Chaplin para humanizar a tecnologia, aproximando-a do “cidadão comum”. Somando a queda de preço padrão estável e aplicações úteis levou a computação pessoal a escritórios, escolas e casas, impulsionando comunicação, produtividade e educação.

Com o tempo, o mercado de PCs se comoditizou. Com margens ficaram menores, a diferenciação migrou para camadas de software, serviços e integração. Em 2005, a IBM vendeu sua divisão de PCs para a Lenovo, por entender que seu foco estratégico deveria ser consultoria, software corporativo e infraestrutura de alto valor. É um paradoxo interessante, a empresa que catalisou a era do PC acabou deixando esse mercado para priorizar áreas mais alinhadas à sua estratégia de longo prazo.

Padronização de hardware: a arquitetura x86 e o barramento de expansão criaram uma base comum para inovação incremental.

Abertura documentada: a publicação do hardware e do BIOS fomentou um ecossistema amplo de periféricos e software.

Decisões de licenciamento: o modelo da Microsoft para o MS-DOS permitiu a adoção transversal por múltiplos fabricantes.

Ecossistema de aplicações: com destaque para a planilha, que justificou a compra e consolidou o PC como ferramenta de negócios.

Efeito rede: mais PCs significaram mais desenvolvedores, o que gerou mais programas, incentivando mais compras, em um círculo virtuoso.

Arquiteturas abertas aceleram mercados, ainda que reduzam o controle do originador. A IBM catalisou um padrão ao qual ela própria não conseguiu impor regras proprietárias depois.

Licenciamento inteligente cria plataformas: Ao não reter exclusividade do MS-DOS, a Microsoft semeou a onipresença do seu software, o que mais tarde favoreceria o Windows.

Killer apps mudam o jogo. Hardware sem casos de uso claros não escala: A planilha alterou a curva de adoção empresarial.

Tempo de mercado importa: Um produto “bom o bastante” entregue rápido, com documentação e parceiros, vence soluções isoladas e incompatíveis.

Comoditização é inevitável: Diferenciação migra para serviços, integração e experiência, exigindo ajustes estratégicos conforme o ciclo de vida da tecnologia.

O IBM PC não foi o primeiro computador pessoal, porém foi o catalisador que transformou um mosaico incompatível em um padrão global. Suas escolhas de design, a arquitetura aberta, o uso de componentes prontos e a parceria com a Microsoft criaram uma plataforma que moldou a computação pessoal moderna. Até hoje, muito do que usamos carrega o DNA daquela máquina de 1981, lembrando que decisões estratégicas, mesmo com efeitos colaterais inesperados, podem moldar indústrias inteiras e a nossa relação com a tecnologia.

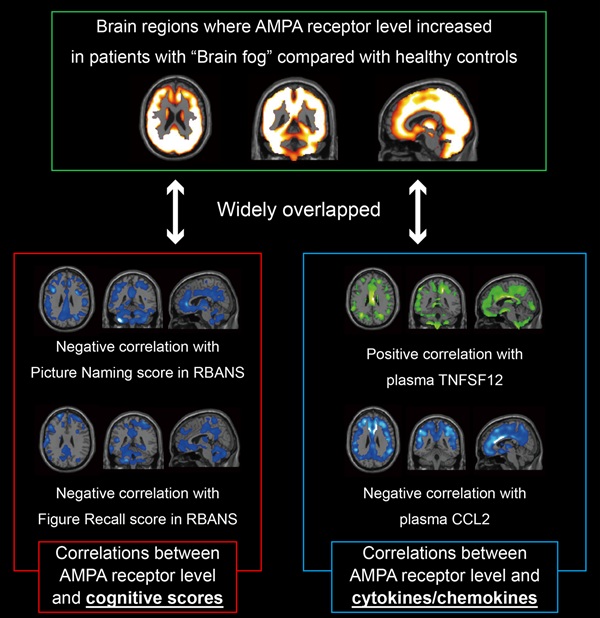

A COVID longa é uma condição crônica que provoca problemas cognitivos conhecidos como névoa mental, porém seus mecanismos biológicos seguem em grande parte obscuros. Agora, em uma pesquisa conduzida no Japão, utilizou uma técnica de imagem inédita para visualizar receptores AMPA, moléculas centrais para memória e aprendizagem, no cérebro vivo. O trabalho mostrou que uma maior densidade desses receptores em pessoas com COVID longa está ligada à gravidade dos sintomas, o que coloca essas moléculas no foco como possíveis biomarcadores diagnósticos e alvos terapêuticos.

Mesmo passados anos desde o início da pandemia de COVID-19, os efeitos da infecção pelo SARS-CoV-2 não estão totalmente esclarecidos. Isso é especialmente verdadeiro para a COVID longa, um quadro que pode surgir após a fase aguda e que reúne sintomas persistentes. Entre os mais comuns e incapacitantes está a disfunção cognitiva, muitas vezes chamada de névoa mental, que atinge mais de oitenta por cento das pessoas com esse diagnóstico. Diante de centenas de milhões de casos no mundo, a COVID longa representa um grande desafio na saúde pública e na economia, porque compromete a capacidade de trabalhar e realizar atividades diárias.

Apesar de sua prevalência, as causas subjacentes da COVID longa e da névoa mental permanecem difíceis de definir. Estudos de imagem apontaram alterações estruturais no cérebro, mas não identificaram as disfunções moleculares diretamente responsáveis pelos sintomas. Observar as moléculas que regem a comunicação entre neurônios é tarefa complexa, por isso faltavam biomarcadores objetivos para confirmar o diagnóstico ou para orientar terapias alinhadas a mecanismos.

Para enfrentar essa lacuna, a pesquisa partiu da hipótese de que haveria expressão alterada de receptores AMPA, elementos essenciais para a plasticidade sináptica, a memória e a aprendizagem, hipótese apoiada por achados em transtornos psiquiátricos e neurológicos. Com isso, foi aplicada uma metodologia de PET com traçador [11C]K-2 voltada a receptores AMPA, capaz de visualizar e quantificar a densidade desses sítios no cérebro humano, oferecendo uma janela direta para a bioquímica das sinapses.

Comparando dados de trinta pessoas com COVID longa a oitenta indivíduos saudáveis, a pesquisa encontrou um aumento notável e disseminado na densidade de receptores em diferentes regiões cerebrais do grupo afetado. Essa elevação correlacionou-se de forma direta com a gravidade do prejuízo cognitivo, sugerindo um elo claro entre a alteração molecular e os sintomas relatados. Além disso, concentrações de marcadores inflamatórios também se correlacionaram com os níveis dos receptores, sinalizando uma possível interação entre inflamação e expressão sináptica.

Tomados em conjunto, os achados representam um passo decisivo para questões ainda em aberto sobre a COVID longa. O aumento sistêmico de receptores AMPA fornece uma explicação biológica para a névoa mental e aponta um alvo concreto para intervenções. Fármacos que atenuem a atividade desses receptores despontam como abordagem plausível para mitigar o quadro cognitivo, hipótese que precisa ser testada com desenho clínico rigoroso e monitoramento de segurança. A análise também mostrou que os dados de imagem distinguem pacientes e controles com cem por cento de sensibilidade e noventa e um por cento de especificidade.

Embora sejam necessários novos esforços para chegar a soluções definitivas, o trabalho indica uma direção promissora. Reconhecer a névoa mental como condição clínica legítima ajuda a organizar linhas de cuidado, a planejar protocolos de acompanhamento e a acelerar o desenvolvimento de estratégias diagnósticas e terapêuticas que combinem reabilitação cognitiva, manejo de sintomas e intervenções baseadas em mecanismos, respeitando a diversidade de manifestações clínicas observadas nas pessoas afetadas.

Em síntese, a pesquisa esclarece pontos centrais sobre a base biológica da névoa mental na COVID longa e abre caminho para ferramentas diagnósticas objetivas e terapias mais eficazes. Ao conectar relatos de dificuldade de atenção, memória e velocidade de processamento a uma alteração mensurável nos receptores de glutamato, oferece uma ponte entre experiência subjetiva e sinal molecular, e lembra que compreender o que sentimos passa por observar as sinapses em funcionamento, onde a aprendizagem e a memória encontram as marcas de uma doença que ainda estamos aprendendo a decifrar.

Referência:

A COVID longa apresenta-se principalmente com comprometimento cognitivo persistente (Cog-LC), impondo um ônus global substancial e duradouro. Mesmo após a pandemia, permanece uma necessidade mundial crítica por estratégias diagnósticas e terapêuticas direcionadas ao Cog-LC. Ainda assim, os mecanismos neurais subjacentes permanecem pouco compreendidos. Dado o papel central das sinapses na função cerebral, a investigação de alterações moleculares sinápticas pode fornecer insights vitais sobre a fisiopatologia do Cog-LC. Neste estudo, utilizamos PET com [11C]K-2 para caracterizar a densidade de receptores AMPA (AMPARs) na superfície celular pós-sináptica, que são componentes sinápticos cruciais na sinalização cerebral. Empregou-se mapeamento paramétrico estatístico para normalizar espacialmente e aplicar teste t independente em uma comparação baseada em voxels. https://academic.oup.com/braincomms/article/7/5/fcaf337/8258475

Clique em um idioma para traduzir.

Este blog está licenciado sob uma

Licença Creative Commons Atribuição 4.0 Internacional

.

Ouça o artigo: Você já ouviu falar em "conflitos híbridos" ou "guerra da informação...